Turnitin AI検出器の正確性は? 実例とデータ洞察

あなたは、自分自身で完全に書いたエッセイを提出しました—AIも、近道も一切使っていません。しかし、その後、TurnitinがそれをAI生成と判断します。今、あなたは「この検出システムの精度は一体どれほどなのだろう?」と疑問に思っているはずです。この疑問を持つのは、あなただけではありません。

この記事では、TurnitinのAI検出ツールが何であるか、どのように動作するのか、そして—最も重要なポイントとして—どのような要因があなたの文章にフラグを立てる原因となるのかを詳しく解説します。また、実際のデータや体験から、その信頼性についても考察していきます。

さあ、TurnitinのAIスコアの裏に隠された真実を一緒に探っていきましょう。

TurnitinのAI検出器は正確なのか? – 公式データが示す実態

Turnitinは、ChatGPTなどのAIツールが生成または言い換えたコンテンツを検出するため、2023年に公式のAIライティング検出技術を導入しました。これにより、学術の誠実性を支え、学生への誤った非難を防ぐことを目指しています。このシステムの精度を理解するために、Turnitinが公開しているデータや判断を見ていきます。

TurnitinのAI検出器の動作原理

TurnitinのAIライティング指標は、提出されたテキストを分析し、各部分がどの程度AI生成であるかをスコアリングする仕組みです。具体的には、単語の使用法、文章構造、表現の統計的パターンを、GPT-3やGPT-4のような大規模言語モデル(LLMs)の典型的なライティングスタイルと比較します。AIが生成した文章は、人間の文章に比べて単語のパターンがより予測可能であるため、各セグメントがどれだけその傾向に沿っているかを判断しているのです。

システムがAI生成と判断したコンテンツが見つかると、さらに二次の検出層で、その内容がAIツール(例:QuillBot)で言い換えられたかどうかを判断します。この二段階のアプローチにより、直接生成されたAI文章と言い換えられたコンテンツの両方を正確に識別できるようにしています。

正確性に関するTurnitinの見解

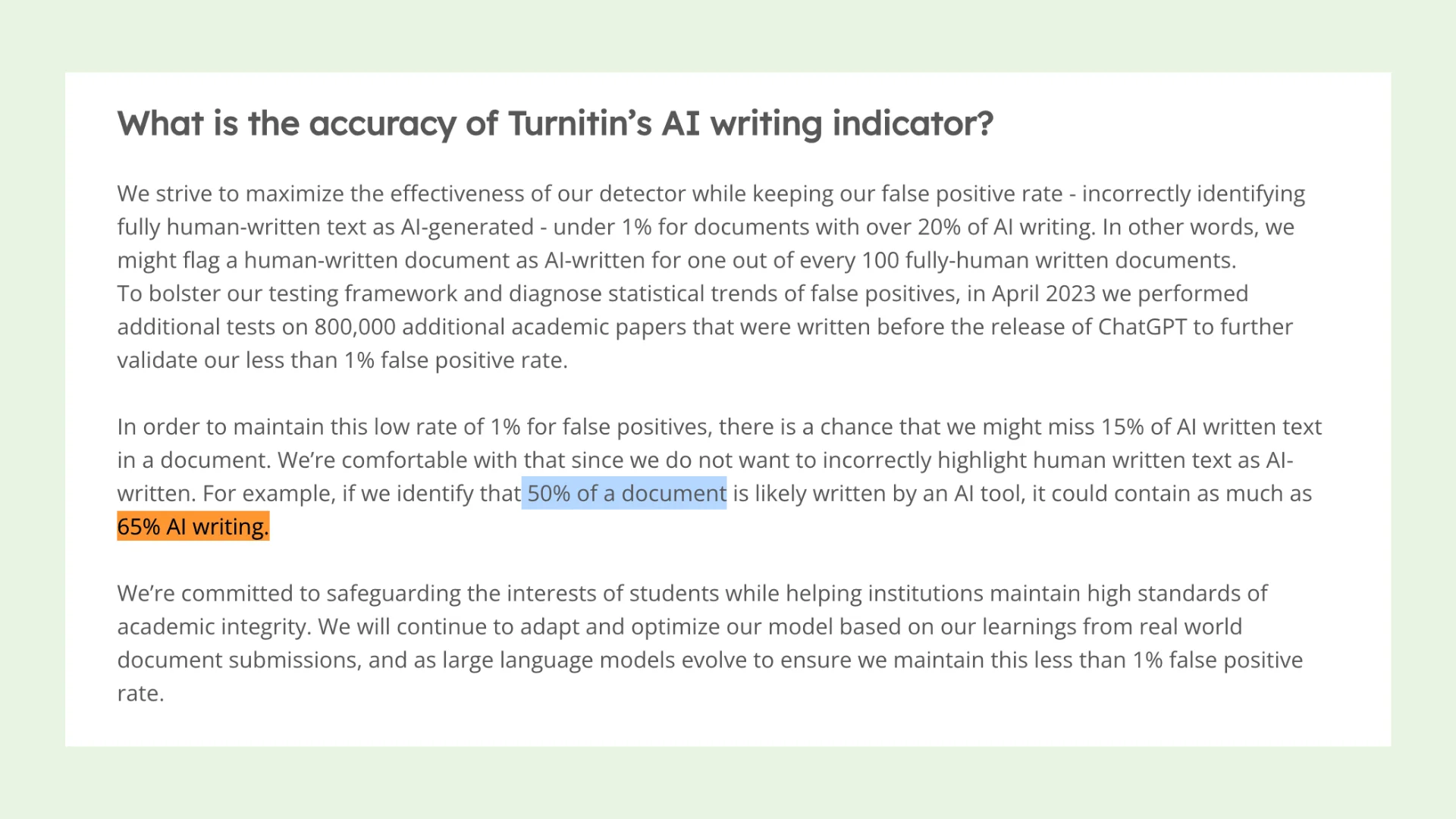

Turnitin自身のデータによれば、システムはAIライティングの割合が20%以上の文書に対して、偽陽性率を1%未満に抑えるよう設計されています。つまり、100件の人間による論文のうち、誤ってAI生成と認識されるのは1件にも満たないということです。この主張の裏付けとして、ChatGPT導入以前に書かれた80万件の学術論文が、実際の人間によるライティングの基準としてテストに用いられました。

しかし、偽陽性率を低く保つために、Turnitinはトレードオフとして、AI生成コンテンツの約15%を見逃す可能性があることも認めています。例えば、文書の50%がAIによって書かれていると示された場合、実際にはその割合が65%に近い可能性があります。これは、本物の人間の文章を不当に非難しないための慎重な姿勢を示しています。

(出典: Turnitin)

精度向上のための最近の改良

システムの性能を高めエラーを減らすため、Turnitinはいくつかのアップデートを実施しました。内部テストに基づくこれらの改良は次の通りです:

低評価AIスコアへのアスタリスク表示:報告書では、AIスコアが20%未満の場合にアスタリスクを付け、これらの結果は信頼性が低く、偽陽性となるリスクが高いことを示しています。

最小語数の引き上げ:AI検出の実施にあたり、語数の閾値が150語から300語に引き上げられました。Turnitinは、文書が長いほど検出結果の正確性が高まることを確認しました。

序論と結論の検出方法の見直し:論文の冒頭や末尾(序論・結論)で偽陽性が発生しやすいことを受け、これらの部分の解析方法が変更されました。

AIによる言い換え検出

Turnitinには、コンテンツが最初にAI生成としてフラグ付けされた後に、AIで言い換えられた部分を検出するツールも備わっています。この仕組みは、全体の偽陽性率に影響を与えないよう設計されています。しかし、場合によっては、言い換え検出ツールがどの程度のAI関与があったかを誤って判断してしまうこともあります:

実際には言い換えられていないにもかかわらず、AI生成とAIによる言い換えの両方としてラベル付けされる場合、または

AI生成されたテキストの一部が言い換えられていたことに気付かない場合がある。

TurnitinのAI検出器は非ネイティブ英語ライターに不利か?

Liangら(2023)による懸念

2023年、研究者のLiangらは、AIライティング検出器が非ネイティブ英語ライター、すなわち英語学習者(ELL)作家に対して不公平なバイアスを持つ可能性を指摘しました。この結論は、すべて150語未満の91本のTOEFL練習エッセイを分析した結果に基づいており、この研究は学界で大きな議論を呼び、一部のTurnitinユーザーがより詳細な説明を求めるきっかけとなりました。

Liang, W., Yuksekgonul, M., Mao, Y., Wu, E., & Zou, J. (2023). GPT detectors are biased against non-native English writers. arXiv preprint arXiv:2304.02819.

これに対し、Turnitinは独自の研究を発表し、2023年10月に、AIライティング検出器がELL作家に対して統計的に有意なバイアスを示すかどうかを検証しました。

Turnitinの調査結果

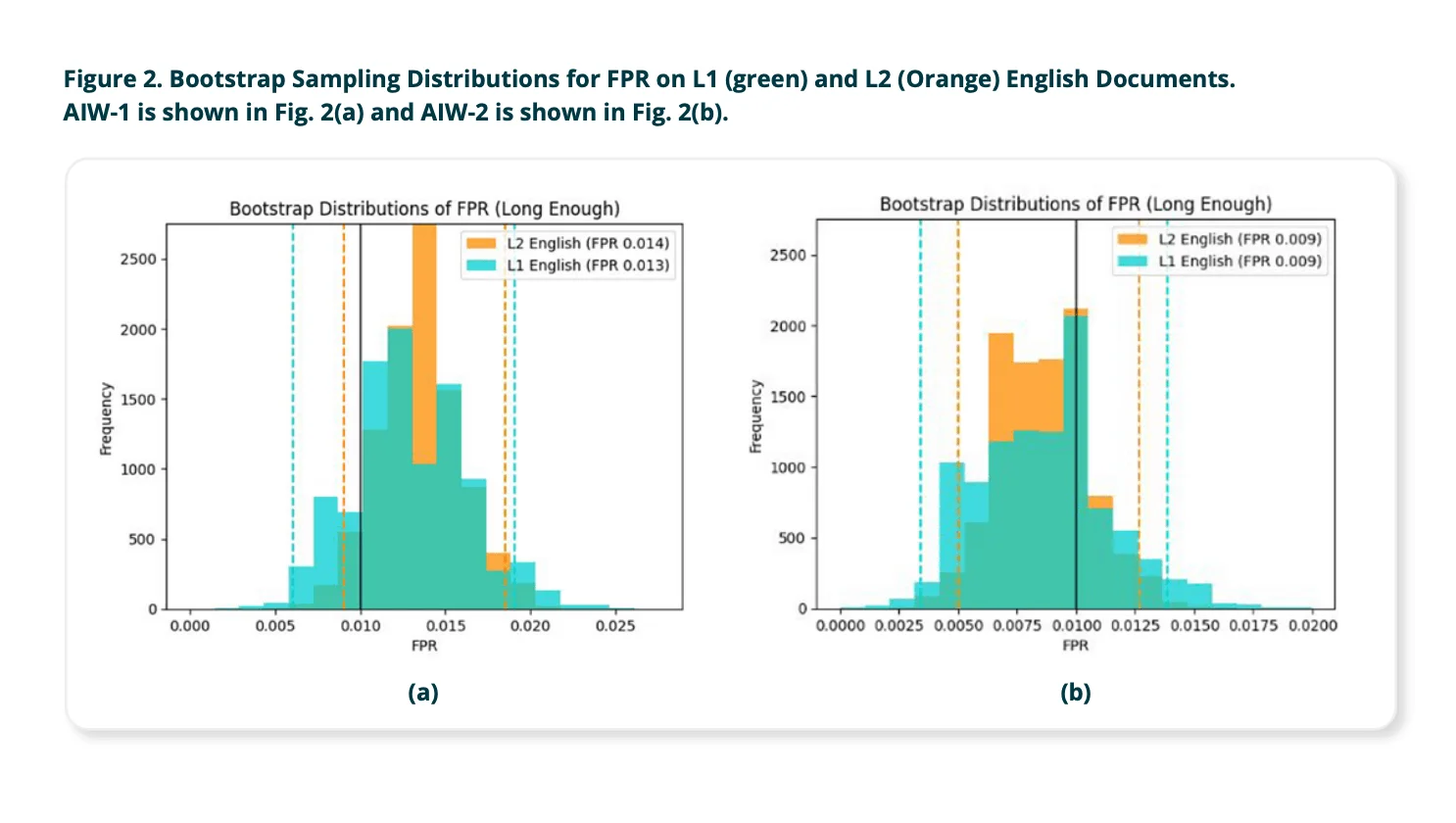

Turnitinは、複数のオープンな学術データセットから集めた何千もの実際の学生エッセイを用いて、AIライティング検出器をテストしました。これらの提出物はネイティブ英語話者(L1作家)とELL作家(L2作家)の両方を含み、文章の長さに応じて以下のように分類されました:

短いテキスト: 150~300語

長いテキスト: 300語以上

調査結果は以下の通りです:

長いテキスト(300語以上)の場合:

検出器が人間の文章を誤ってAI生成と判断する偽陽性率は、ELL作家とネイティブ英語作家間でほぼ同等で、その差はごく僅かで統計的に有意ではないことが分かりました。

➡️ 結論: 提出文書が必要な語数(300語以上)を満たしている場合、TurnitinのAI検出器はELL作家に対して明確なバイアスを示しません。

短いテキスト(300語未満)の場合:

全体として偽陽性率が上昇し、ネイティブ作家と非ネイティブ作家の間の差もより顕著になりました。Turnitinは、短いサンプルでは十分な言語情報(シグナル)が得られず、AIモデルが人間の文章とAI生成文章を正確に区別できないと認めています。

➡️ そのため、短い提出物全体では検出結果の信頼性が低く、特にELL作家にとっては不利な結果となる可能性があります。

こうした課題を踏まえ、Turnitinはシステムの更新を行い、300語以上の提出物のみを評価対象とすることで、偽陽性を減らし、正確性の向上を図っています。

最終結論

Turnitinは、提出物が最低300語以上であれば、AIライティング検出器が非ネイティブ英語作家に対してバイアスを示さないと結論付けました。同社は、大規模言語モデル(LLMs)が進化を続ける中で、システムの公平性と信頼性をさらに高めるための取り組みを継続していくと強調しています。

大学はどのように対応しているのか?

Turnitinは自社のAI文章検出ツールの信頼性を主張していますが、すべての学術機関が納得しているわけではありません。多くの大学から、このツールの透明性、信頼性、さらには学生の信頼に及ぼす影響について懸念が示されています。中には、誤った告発のリスクや十分な検証がなされていないことを理由に、この機能を完全に無効化する決断をした大学もあります。以下は、アメリカのヴァンダービルト大学とテンプル大学という2校が、TurnitinのAI検出システムをどのように評価し対応したかの例です。

ヴァンダービルト大学がTurnitinのAI検出機能を無効化した決定

ヴァンダービルト大学は、その有効性と透明性に関する懸念から、TurnitinのAI検出ツールを無効化することを決めました。このツールは、顧客に対して24時間以内という非常に短い予告期間で導入され、オプトアウトの選択肢がありませんでした。大学側は、TurnitinがAI生成テキストを識別するための詳細な手法を公開していない点に疑問を呈しました。Turnitinは1%の偽陽性率を主張していますが、2022年に75,000件の論文が提出された場合、約750件の誤検知が生じる可能性があると指摘されています。他の大学でも、Turnitinの検出ツールに関連して、学生が誤ってAI使用で告発された事例が報告されています。また、研究によれば、このツールは英語を母国語としない書き手の文章をAI生成と誤認しやすく、公平性に関する懸念が高まっています。

テンプル大学におけるTurnitinのAI文章検出ツールの評価

テンプル大学のセンター・フォー・スチューデント・サクセスおよびセンター・フォー・アドバンスメント・オブ・ティーチング ((Temple CAT) による調査)では、120の文章サンプルを用い、完全に人間が書いた文章、完全にAIが生成した文章、検出回避のためにパラフレーズされたAI生成文章、そしてAIと人間の寄与が組み合わされたハイブリッド文章の4カテゴリーに分類して評価を行いました。ハイブリッド文章は、例えばAI生成のコンテンツが人間によって編集されたものや、人間が書いた文章がAIによって改善されたものなど、実際の教育現場をシミュレーションしたものでした。すべてのサンプルはTurnitinのAI検出ツールで解析されました。

結果:

人間が書いた文章: 93%が正確に識別されました。

完全にAI生成の文章: 77%が正しく検出されました。

パラフレーズされたAI生成文章: 検出率は63%に下がりました。

ハイブリッド文章: 正しく識別できたのはわずか43%で、検出された部分と実際のAI生成部分との一致が乏しかったです。

全体として、TurnitinのAI検出ツールは約86%の正確性でAI使用を検出しましたが、特にパラフレーズされた文章やハイブリッド文章においては14%の誤検出率を示しました。

議論と含意:

TurnitinのAI検出ツールは、純粋に人が書いた作品を確実に識別できるため、AIの使用が全面的に禁止されている場合には非常に有用です。なぜなら、0%のAIスコアはほぼ確実に人間による著作であることを示すからです。しかし、このツールは偽陽性を抑える設計となっているため、時として人間が作成した内容を過大評価し、一部で不正確な判断を下す傾向があります。特に問題なのは、ツールがハイブリッド文章の場合にどの部分がAI生成かを明確に示さない点で、これは現代の教育現場でますます見られる状況です。

また、盗作検出と異なり、AI生成の文章には直接リンクできる原典が存在しないため、警告された部分に元の出典情報が付与されません。このような検証可能なリンクがないことが、教員が警告された内容を独自に確認することを難しくし、結果としてTurnitinのアルゴリズムに対する透明性欠如を補完する信頼を要求する状況となっています。

Turnitinについて一般ユーザーが語ることは?

ここでは、特に学生を中心とした一般ユーザーがTurnitinのAI検出ツールにどのような反応を示しているかを見てみましょう。可能性を評価する意見もある一方で、その精度や公正さに対して深刻な疑問を呈する声も多く聞かれます。Redditといったプラットフォームでのオンライン議論では、偽陽性や結果の不一致に対する不満が増加している様子が伺えます。ユーザーの多くは、自分たちのオリジナルの人間による執筆内容が、誤ってAI生成と判断されていると報告しています。

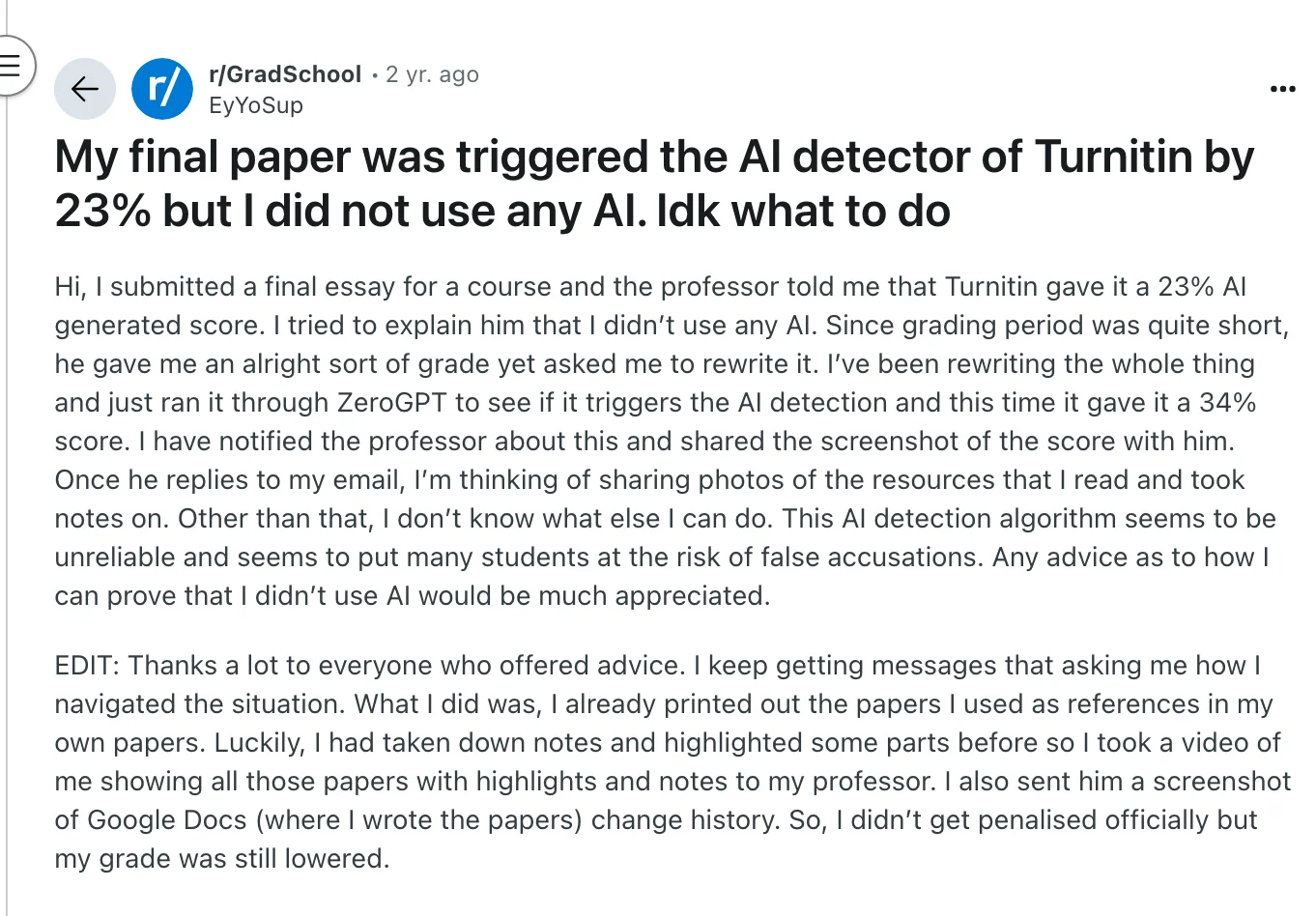

Redditでのユーザーの懸念

複数のRedditユーザーが、TurnitinのAI検出ツールによって不当に識別された経験を共有しています:

偽陽性: EyYoSupが報告したところ、全くAIを使用していなかったにもかかわらず、最終論文の23%がAI生成と判定されました。別のユーザーは、信頼できるウェブサイトからの個人的な分析と調査に基づく内容に対して、48%という驚くべきAIスコアが付けられたと述べています。

学校側が認識する不正確さ: 一部の学校はこうした問題を認識しているようです。ある投稿者は、自校ではTurnitinのAI検出結果を参考情報としてのみ扱い、最終的な証拠とはみなしていないと述べ、現行のAI検出システムが100%信頼できるわけではないと認めています。

意見

これらのユーザー報告は、Turnitinの主張と学生たちの実際の経験との間に乖離があることを示唆しています。ツール自体は特定の条件下で有効に機能するものの、特に学生が研究内容を言い換えたり要約する場合、本来の人間の文章が誤って分類される傾向があり、公平性に問題が生じる可能性があります。透明性や異議申し立ての制度が整っていないまま、採点や学術的判断に過度に依存することは、何も不正をしていない学生に不利益をもたらすリスクがあると言えるでしょう。

なぜあなたのエッセイがAIと検出されるのか

Turnitinがあなたのオリジナル作品をAI生成と誤判すると、多くの学生が混乱や悔しさを感じます。もしこのような事態に遭遇しても、決してあなただけではありません.

以下は、人間が書いたエッセイが誤ってフラグされる具体的な理由です:

1. 過度に形式的またはありふれた言葉遣い

AIが生成するテキストは、洗練され中立的な印象を与えることが多いです。もしあなたのエッセイが完璧な文法で書かれ、短縮形を使わず、まるで教科書のような文体であれば、たとえあなた自身の作品であっても、検出器がそれをAI生成と誤解する可能性があります。

2. 個性的な表現や文のバリエーションの欠如

AIツールは、予測可能な文型の文章を生成する傾向があります。文章に変化やニュアンス、個性が感じられない場合、機械的なパターンに似てしまうかもしれません。

3. オンライン情報の過度なパラフレーズ

たとえ徹底的にリサーチし、自分の言葉で言い換えたとしても、人気のあるオンラインコンテンツの要約が元の内容に非常に近いと、公開データを参照するAIのスタイルと似通ってしまう可能性があります。

4. 文章量が短いまたは単語数が少ない

Turnitinは、300語未満のエッセイが誤ってフラグされやすいと指摘しています。短い文章はAI検出器が利用できる文脈が乏しく、誤認識のリスクが高まります。

5. 繰り返しが多い構成や一貫性のないアイデア

AIによる文章は、時に繰り返しが多く、論理的ではあるが深みを欠く場合があります。リストや同じフレーズの繰り返し、または不十分なつなぎがあると、AI生成の文章の流れに似てしまう可能性があります。

6. 一般的またはありふれたテーマ

気候変動、ソーシャルメディアの利点、学生服など、オンラインで広く議論されるテーマは、AIモデルにとって非常に馴染み深いものです。議論が一般的なパターンに沿っていたり、よく知られたフレーズを使用している場合、検出器がそれをAI作成と判断する恐れがあります。

7. 引用および参考文献の形式

場合によっては、Turnitinの検出器が、AIのトレーニングデータに非常に近い引用形式や参考文献リストをフラグすることがあります。これは稀なケースですが、特に情報源が広く利用され、ありふれた表現で記されている場合に起こりえます。

学生の皆さんへ:TurnitinのAI検出システムでフラグが立てられた場合の対処方法

実際にはAIを使っていないのに、AI使用の疑いでフラグが付けられるのは、非常に悔しく不公平に感じるかもしれません。しかし、落ち着いて対応しましょう。あなたの作業を説明し、弁明するための具体的な手順があります。

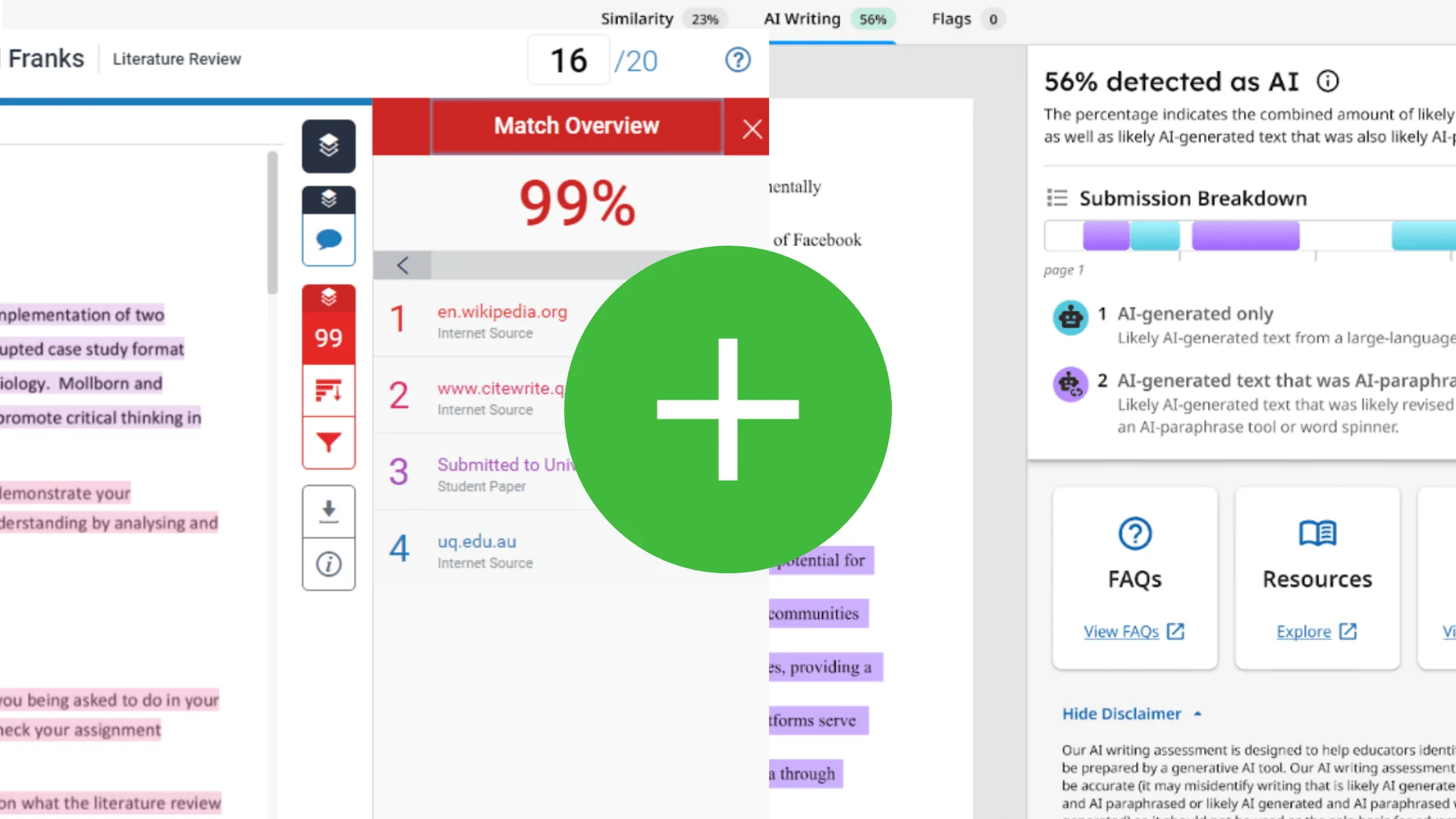

1. 冷静にレポートをチェックする

まず、Turnitin レポートのスコアを注意深く確認してください。Turnitinは論文全体を一概にAI作成と断定するのではなく、どの範囲がAI生成の可能性があるかのパーセンテージを示しています。どの部分にフラグが付けられているかを確認し、「これって過度に洗練されすぎていなかったか、または繰り返し表現が多くなっていなかったか、典型的なAIの出力に似ていなかったか」と自問してみてください。

2. 作文プロセスの証拠を収集する

自分の作品がオリジナルであることを証明する最善の方法は、作成過程を示すことです:

下書きを見せる – エッセイを書いた際にGoogleドキュメントやWordを使用しているなら、版履歴や変更履歴機能を利用して、作成プロセスを明確にしましょう。

スクリーンショットや動画を撮影する – 手書きのノート、アウトライン、もしくはハイライトが付けられた印刷された調査資料などを記録しておくと、証拠として有効です。

参考文献を提出する – 外部情報源を使った場合は、その資料とともに、どのように情報を活用したかを説明するメモを指導教員に提示しましょう。

3. 指導教員に相談する

丁寧に連絡を取り、文章が自分自身のものであること、そして作成過程の証拠を共有してください。どのようにアイデアを展開していったのかを説明する意思があることを伝えれば、多くの教員は対立よりも透明性と誠実な努力を評価してくれるでしょう。

4. 再審査または再評価を申し出る

もし学校の方針で許されるなら、セカンドオピニオンや学術的な上訴を申し出ることも可能です。ポリシーや自身の学生としての権利について、明確な説明を求めることをためらわないようにしてください。

教師はどのようにTurnitinのAI検出レポートを活用すべきか?

教師はTurnitinのAI検出レポートを、注意深く、文脈を踏まえ、そして積極的なコミュニケーションをもって扱うべきです。これは最終的な判断材料とするのではなく、学術全体の情報の一部として位置付けるためです。以下に、これらのツールを責任あるかつ公正に使用するための方法を示します:

1. スコアだけに頼らない

TurnitinのAIスコアは、不正行為の証拠ではありません。あくまで教師の判断を補佐するためのものであり、完全に代替するものではありません。高い割合が示されたとしても、自動的に学生の不正を意味するわけではありません。

2. 過去の作品と比較する

対象の課題がフラグ表示されている場合、学生の以前の提出物と並べて確認してください。文体、構造、語彙、または複雑さに違いが見られるかどうかを確認し、急な変化があれば文脈の中で意味を考える必要があります。

3. 他のツールで検証する

同じ文書を異なるAI検出ツールにかけることで、さらに詳しい情報が得られる場合があります。結果にはばらつきがあるかもしれませんが、複数のツールで同様の指摘があれば、詳細に調査する価値があるでしょう。

4. 学生と直接話し合う

尊重の念をもって学生と対話しましょう。文章作成のプロセスや参照した情報源、作業のスケジュールについて質問し、フラグが付けられた部分を見せてください。もし可能なら、ドラフト、メモ、またはバージョン履歴(たとえばGoogle Docs内)を提供してもらい、背景を把握することが有益です。

5. 修正や書き直しの機会を与える

意図的な不正使用が明確に示されない限り、学生に修正や書き直しの機会を与えるのが望ましいです。多くの学生は、自分の文章がアルゴリズムによって誤解される可能性に気付いていないものです。

6. 所属機関の方針に従う

不正行為があったと判断し、学生が十分な説明を行わない場合は、学校の学術的誠実性に関する手続きに従ってください。ただし、AI検出ツールの限界や偽陽性のリスクも考慮する必要があります。

7. 期待値について事前に明確化する

コース開始時に、AIの使用に関する具体的なガイドラインを設定しましょう。何が許可され、何が許されず、許可される場合にはChatGPTのようなツールの引用方法についても明確にしておくことが大切です。こうした期待を最初に示しておくことで、混乱を避け、信頼関係を築く助けとなります。

FAQ

Q: Turnitin が間違いをすることはありますか?

A: はい、Turnitin も誤判定をする場合があります。盗作検出や AI 検出のツールは役立ちますが、完璧ではありません。特に、一般的な書き方や多く引用される情報に似ている場合、オリジナルの作品が誤って警告されることがあります。

Q: Turnitin で36%の場合は大丈夫ですか?

A: 課題の内容によります。盗作検出については、36%の Turnitin スコアが、ほとんどが正しく引用された部分で構成されているなら問題ない場合もあります。しかし、AI 検出となると、どの部分が警告されたかや教員の解釈によって、30%の場合でも問題視されることがあります。

Q: Turnitin は本当に信頼できるツールでしょうか?

A: Turnitin は広く利用されているツールですが、完全無欠ではありません。盗作の直接的なテキスト一致は検出しやすいものの、AI 検出はまだ新しい技術で、改善の余地があります。教育者は最終判断としてではなく、参考資料として利用することが望まれます。

Q: Turnitin で70%の場合は問題があるのでしょうか?

A: 盗作に関して70%の類似度スコアは通常、注意すべきサインとされ、詳しいチェックが求められます。AI 検出においては、70%だからといって必ずしも不正を意味するわけではありませんが、教員がさらに調査を進める可能性が高まります。

Q: Turnitin の AI 検出機能はどれくらい正確ですか?

A: AI が明確に書いた文章や、人間が書いた文章については高い精度を発揮しますが、人間と AI が混在する文章では判断が難しくなります。AI の文章が言い換えられたり、大幅に編集された場合は、精度がさらに落ちる傾向にあります。

Q: 他の AI 検出ツールと比べた場合、Turnitin の精度はどうですか?

A: 独立した研究によると、Turnitinは多くの無料の検出ツールよりも優れた結果を示していますが、それでも完璧ではありません。混合テキストやパラフレーズされた文章では、精度が50%以下になることもあります。GPTZero や Originality.ai など、他のツールは異なる結果を出すことがありますが、それぞれに限界があります。

Q: Turnitin は300語以下の文章に含まれるAI生成部分を検出できますか?

A: 十分な信頼性を持って検出することはできません。短い回答では、Turnitin の AI 検出機能が十分な文脈を把握できず、誤判定のリスクが高まります。

最終考察

TurnitinのAI検出器は必ずしも正確ではなく、検出されたからといって直ちに不正行為を意味するわけではありません。これらのツールはまだ発展段階にあり、特にAI生成コンテンツに見られるパターンを反映している場合には、人間の文章を誤って識別する可能性があります。

学生も教育者も、AI検出結果に対しては注意深く、文脈を踏まえた上でオープンに議論する姿勢が求められます。これらのツールがどのように機能し、なぜ誤検出が発生するのかを理解することで、教育におけるAIの利用をより公正で、十分な情報に基づき、また思慮深いものにしていくことができるでしょう。