Le détecteur d’IA de Turnitin est-il précis ? Cas réels

Vous avez soumis une dissertation que vous avez entièrement rédigée vous-même – sans IA, sans raccourcis. Mais voilà que Turnitin la détecte comme générée par une IA. Vous vous demandez alors : ce système de détection est-il vraiment fiable ? Et vous n'êtes pas le seul à vous poser la question.

Dans cet article, nous allons examiner en détail ce qu'est l'outil de détection d'IA de Turnitin, comment il fonctionne et, surtout, quels facteurs peuvent l'amener à signaler votre texte. Nous explorerons également les données réelles et les expériences vécues qui témoignent de sa fiabilité.

Alors, plongeons au cœur du sujet pour découvrir ce qui se cache derrière les scores d'IA de Turnitin.

Quelle est la précision du détecteur d'IA de Turnitin ? – Analyse des données officielles

Turnitin a officiellement lancé sa technologie de détection d'écriture IA en 2023 pour identifier les contenus générés ou paraphrasés par des outils d'IA comme ChatGPT. L'objectif est de soutenir l'intégrité académique tout en minimisant le risque de fausses accusations envers les étudiants. Pour évaluer la précision de ce système, examinons les données et les décisions que Turnitin a partagées publiquement.

Comment fonctionne le détecteur d'IA de Turnitin

L'outil de détection d'écriture IA de Turnitin analyse le texte soumis et évalue chaque segment en fonction de sa probabilité d'avoir été généré par l'IA. Il compare les modèles statistiques d'utilisation des mots, de structure des phrases et de formulation avec le style d'écriture typique des grands modèles de langage (LLM) comme GPT-3 et GPT-4. L'écriture générée par l'IA ayant tendance à suivre des schémas plus prévisibles que l'écriture humaine, le système détermine dans quelle mesure chaque segment du document correspond à un modèle d'IA.

Si l'outil détecte un contenu qu'il considère comme généré par l'IA, il applique une seconde analyse pour déterminer si ce contenu a été paraphrasé à l'aide d'outils d'IA (par exemple, QuillBot). Ce processus en deux étapes permet d'identifier à la fois l'écriture directe issue de l'IA et les contenus d'IA reformulés.

Ce que Turnitin affirme concernant la précision

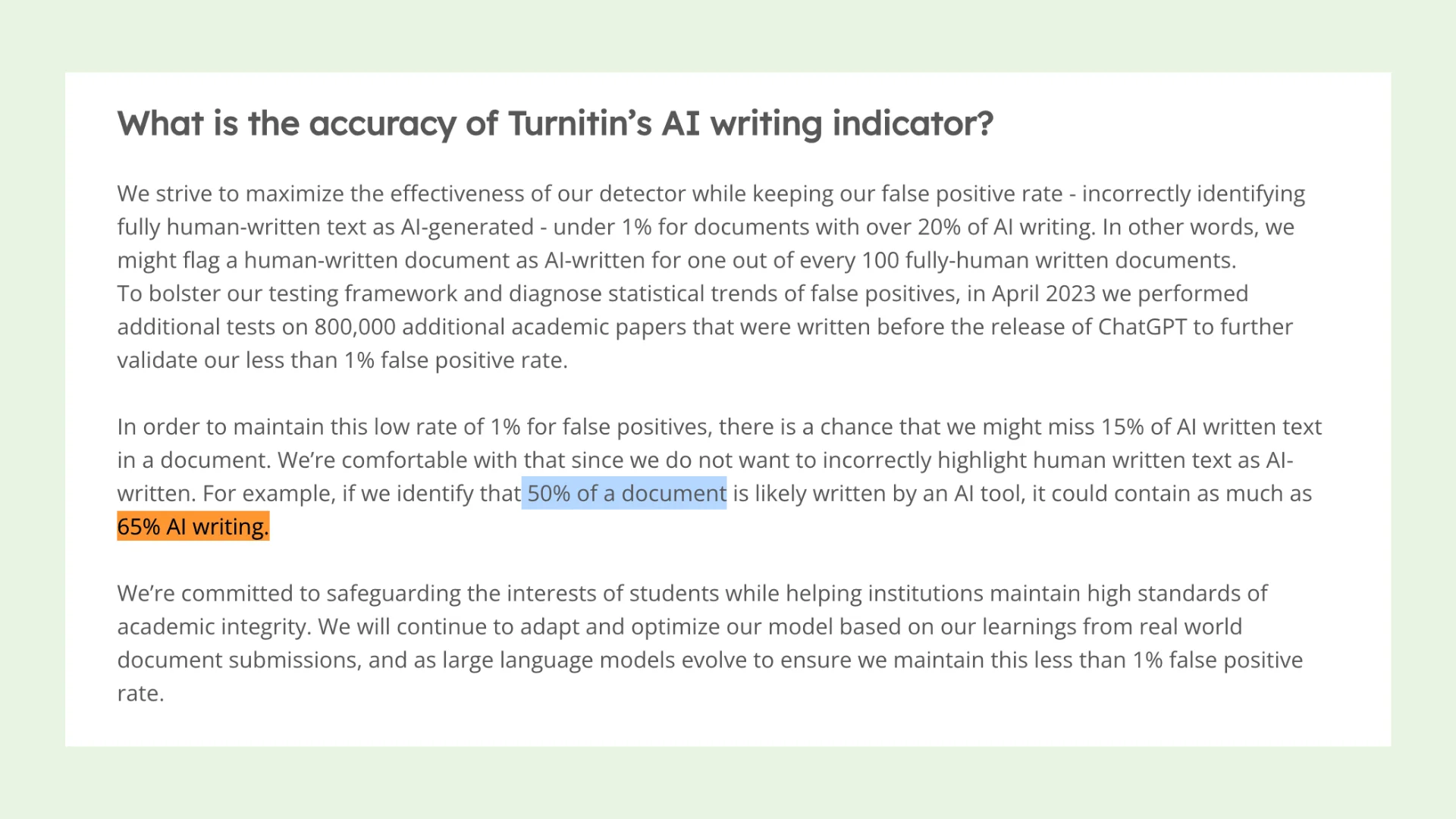

D'après les données fournies par Turnitin, le système est conçu pour maintenir un taux de faux positifs inférieur à 1 % pour les documents contenant plus de 20 % d'écriture IA. Autrement dit, sur 100 travaux rédigés par des humains, moins d'un devrait être incorrectement identifié comme généré par l'IA. Pour étayer cette affirmation, Turnitin a testé son système sur 800 000 articles universitaires rédigés avant l'existence de ChatGPT, en les utilisant comme référence pour l'écriture humaine authentique.

Cependant, pour maintenir un taux de faux positifs aussi bas, Turnitin accepte un compromis : il peut omettre environ 15 % des contenus générés par l'IA. Par exemple, si Turnitin indique que 50 % d'un document a été écrit par l'IA, la proportion réelle pourrait être plus proche de 65 %. Cela reflète l'approche prudente du système, qui préfère éviter d'accuser à tort un travail authentique.

(source : Turnitin)

Ajustements récents pour améliorer la précision

Afin d'améliorer les performances du système et de minimiser les erreurs, Turnitin a mis en place plusieurs mises à jour sur la base de tests internes :

Avertissements avec astérisque pour les scores d'IA faibles : Les scores d'IA inférieurs à 20 % sont désormais signalés par un astérisque dans le rapport, indiquant que ces résultats sont moins fiables et présentent un risque plus élevé de faux positifs.

Nombre minimal de mots augmenté : Le nombre minimal de mots requis pour la détection de l'IA est passé de 150 à 300. Turnitin a constaté que les documents plus longs conduisent à des résultats plus précis.

Modifications apportées à la détection des introductions et conclusions : Turnitin a constaté que des faux positifs se produisaient souvent au début ou à la fin des travaux (par exemple, dans les introductions ou les conclusions). La méthode d'analyse de ces sections a donc été revue.

Détection de la paraphrase par l'IA

Turnitin propose également un outil pour détecter les textes paraphrasés par l'IA, mais il ne s'active que si le contenu a d'abord été signalé comme généré par l'IA. Cela signifie que la vérification de la paraphrase n'affecte pas le taux global de faux positifs. Toutefois, le détecteur de paraphrase peut parfois identifier incorrectement le type d'intervention de l'IA :

Il peut qualifier un texte généré par l'IA à la fois de "généré par l'IA" et de "paraphrasé par l'IA", même si ce n'est pas le cas ;

Il peut ne pas reconnaître qu'un texte généré par l'IA a également été paraphrasé.

Le détecteur d'IA de Turnitin est-il biaisé envers les rédacteurs non anglophones ?

Préoccupation soulevée par Liang et al. (2023) :

En 2023, les chercheurs Liang et ses collègues ont émis la crainte que les détecteurs d'écriture IA puissent être biaisés envers les rédacteurs non anglophones, également appelés apprenants de la langue anglaise (ELL). Leur conclusion était basée sur l'analyse de 91 exercices de rédaction TOEFL, tous contenant moins de 150 mots. Cette étude a suscité de nombreuses discussions au sein de la communauté universitaire et a incité certains utilisateurs de Turnitin à demander une réponse plus détaillée de la part de l'entreprise.

Liang, W., Yuksekgonul, M., Mao, Y., Wu, E., & Zou, J. (2023). GPT detectors are biased against non-native English writers. arXiv preprint arXiv:2304.02819.

En réponse, Turnitin a publié sa propre étude en octobre 2023 pour déterminer si son détecteur d'écriture IA présentait un biais statistiquement significatif envers les rédacteurs ELL.

Qu'a découvert Turnitin ?

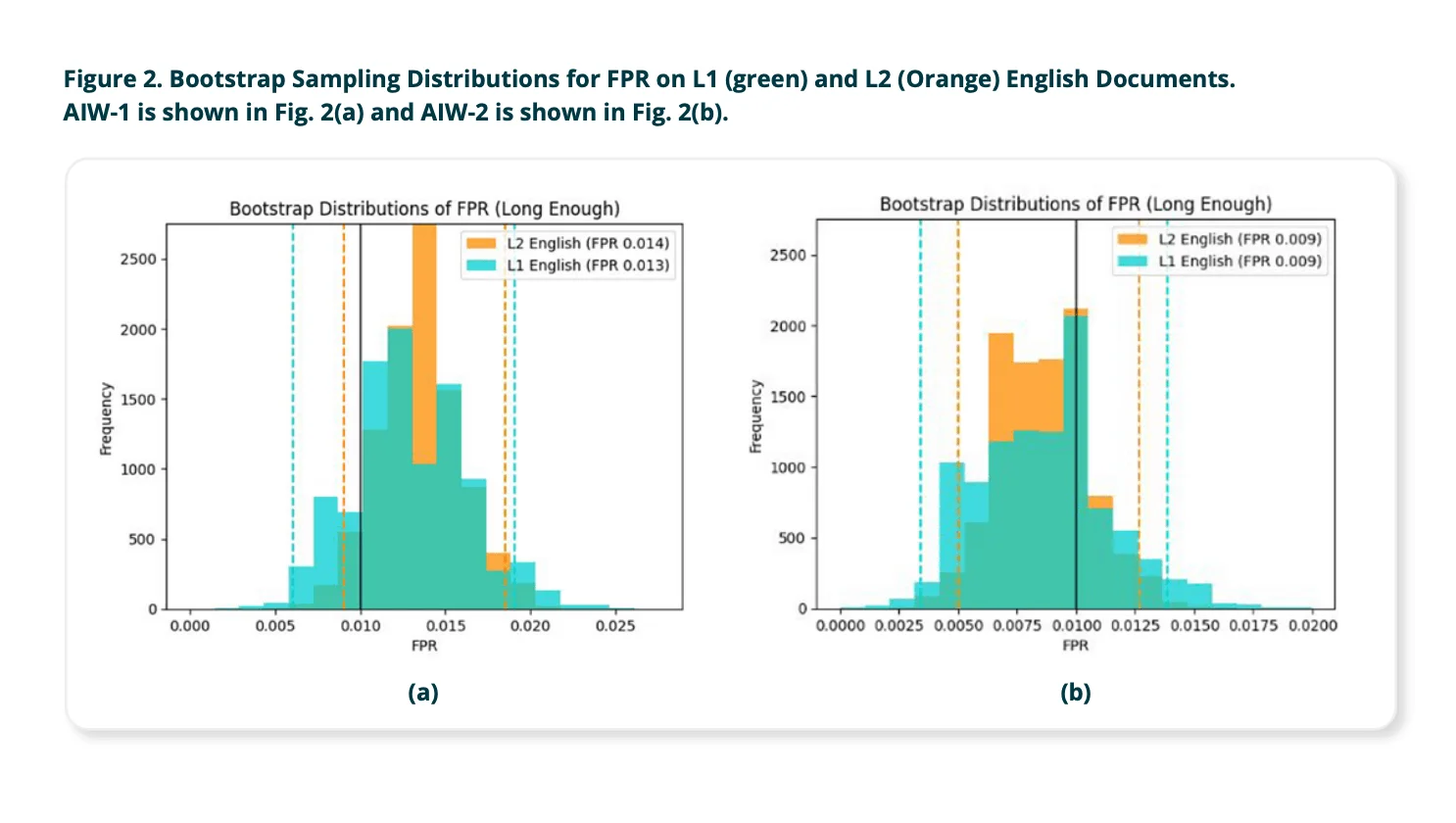

Turnitin a testé son détecteur d'écriture IA en utilisant des milliers de travaux d'étudiants authentiques, provenant de divers ensembles de données universitaires ouverts. Ces travaux étaient soumis par des locuteurs natifs (rédacteurs L1) et des rédacteurs ELL (rédacteurs L2). Les échantillons ont été classés en fonction de leur longueur :

Textes courts : 150–300 mots

Textes longs : 300 mots ou plus

Voici les conclusions :

Pour les textes longs (300 mots ou plus) :

Le taux de faux positifs (c'est-à-dire la probabilité que le détecteur signale à tort un texte rédigé par un humain comme généré par l'IA) était presque identique pour les rédacteurs ELL et les rédacteurs anglophones. La différence était si minime qu'elle n'était pas statistiquement significative.

➡️ Conclusion: Lorsque les documents respectent le nombre minimal de mots, le détecteur d'IA de Turnitin ne présente pas de biais mesurable envers les rédacteurs ELL.

Pour les textes courts (moins de 300 mots) :

Le taux de faux positifs a augmenté globalement, et l'écart entre les rédacteurs natifs et non natifs est devenu plus important. Turnitin a reconnu que les échantillons courts ne contiennent pas suffisamment d'informations linguistiques ("signal") pour que le modèle d'IA puisse distinguer avec précision l'écriture humaine de celle générée par l'IA.

➡️ Cela rend le détecteur moins fiable pour tous les travaux courts, et potentiellement encore plus pour les rédacteurs ELL.

Par conséquent, Turnitin a mis à jour son système pour n'évaluer que les travaux contenant au moins 300 mots, afin de réduire le nombre de faux positifs et d'améliorer la précision.

Conclusion finale :

Turnitin conclut que son détecteur d'écriture IA ne présente pas de biais envers les rédacteurs non anglophones, à condition que le travail respecte la limite minimale de 300 mots. L'entreprise a également souligné ses efforts constants pour améliorer l'équité et la fiabilité de son système, en particulier à mesure que les grands modèles linguistiques (LLM) continuent d'évoluer.

Comment les universités réagissent-elles ?

Bien que Turnitin défende l'intégrité de son outil de détection d'écriture basée sur l'IA, toutes les institutions académiques ne sont pas entièrement convaincues. Plusieurs universités ont exprimé des préoccupations quant à la transparence, la fiabilité et l'impact potentiel de cet outil sur la confiance des étudiants. Certaines ont même choisi de désactiver complètement cette fonctionnalité, craignant des accusations erronées et un manque de validation suffisant. Voici des exemples de la manière dont deux universités américaines, l'université Vanderbilt et l'université Temple, ont évalué et répondu au système de détection d'IA de Turnitin.

Décision de l'université Vanderbilt de désactiver l'outil de détection d'IA de Turnitin

L'université Vanderbilt a pris la décision de désactiver l'outil de détection d'IA de Turnitin en raison de doutes quant à son efficacité et à sa transparence. L'outil a été activé avec un préavis de moins de 24 heures, sans possibilité pour les clients de s'y soustraire. Vanderbilt a mis en cause le fonctionnement du détecteur, car Turnitin n'a pas communiqué de méthodes détaillées permettant d'identifier les textes générés par l'IA. Bien que Turnitin annonce un taux de faux positifs de 1 %, Vanderbilt a souligné qu'avec 75 000 travaux remis en 2022, cela pourrait se traduire par environ 750 signalements erronés d'utilisation de l'IA. D'autres universités ont également rapporté des cas d'étudiants injustement accusés d'avoir utilisé l'IA, souvent en raison du détecteur de Turnitin. De plus, certaines études suggèrent que le détecteur est plus susceptible de signaler comme étant générés par l'IA des textes rédigés par des personnes dont l'anglais n'est pas la langue maternelle, ce qui pose des problèmes d'équité.

Évaluation du détecteur d'écriture basé sur l'IA de Turnitin à l'université Temple

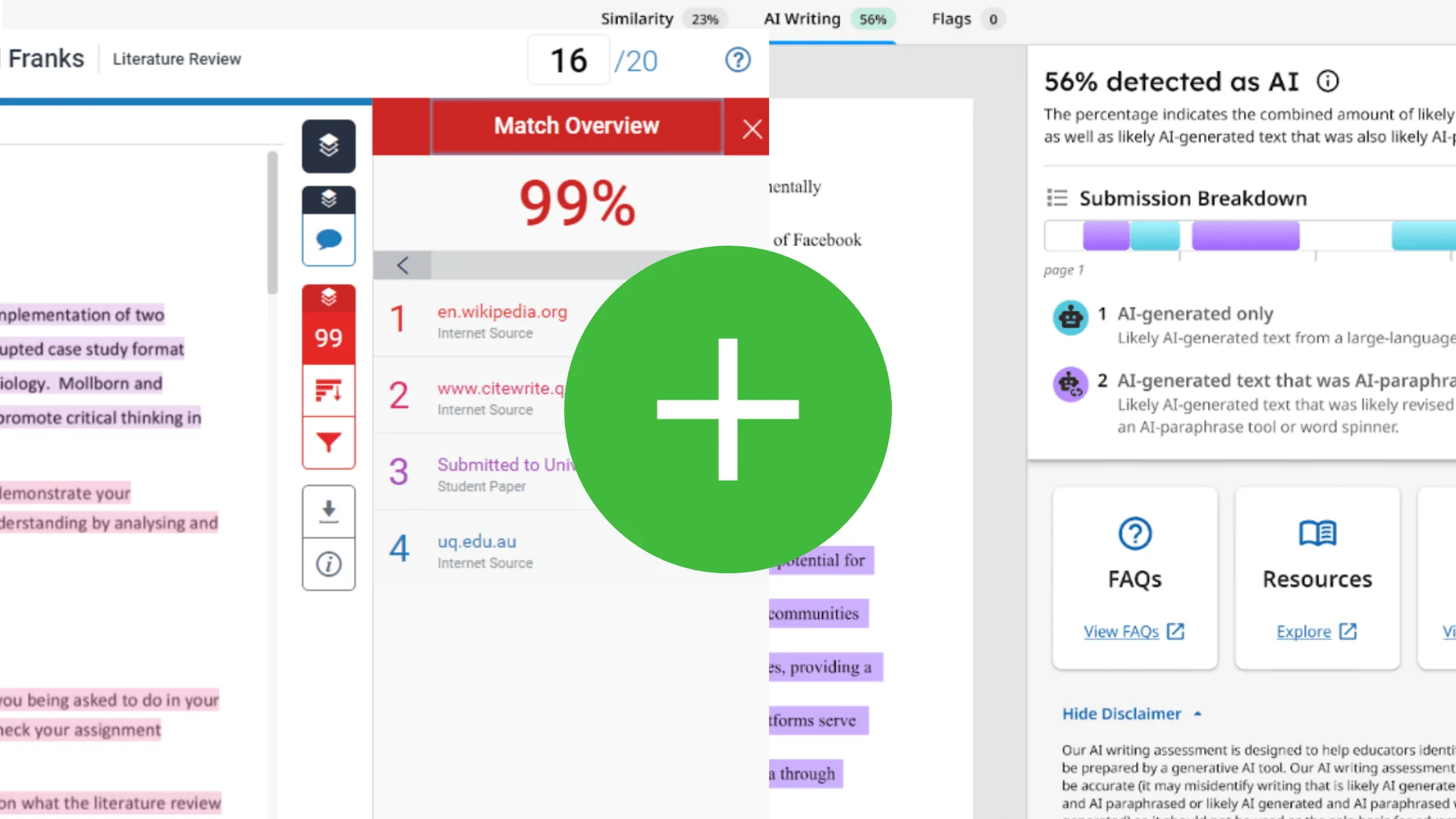

Des chercheurs du Centre pour la réussite étudiante et du Centre pour l'avancement de l'enseignement de l'université Temple (Temple CAT) ont mené une étude sur Turnitin, en utilisant 120 échantillons de textes répartis en quatre catégories : textes entièrement rédigés par des humains, textes entièrement générés par l'IA, textes générés par l'IA et dissimulés (paraphrasés pour éviter la détection), et textes hybrides combinant des contributions humaines et de l'IA. Ces derniers simulaient des situations réelles et pédagogiques, comme du contenu généré par l'IA, puis modifié par des humains, ou du contenu rédigé par des humains, puis amélioré par l'IA. Tous les échantillons ont été analysés à l'aide du détecteur d'IA de Turnitin.

Résultats :

Textes rédigés par des humains : 93 % identifiés avec précision.

Textes entièrement générés par l'IA : 77 % détectés avec précision.

Textes générés par l'IA et dissimulés : La détection a chuté à 63 %.

Textes hybrides : Seulement 43 % identifiés correctement ; les signalements du détecteur ne correspondaient pas aux portions réellement générées par l'IA.

Globalement, le détecteur d'IA de Turnitin a atteint une précision d'environ 86 % dans la détection de l'utilisation de l'IA, mais a affiché un taux d'erreur de 14 %, particulièrement pour les textes dissimulés et hybrides.

Discussion et implications :

Le détecteur d'IA de Turnitin identifie de façon fiable les travaux entièrement rédigés par des humains et s'avère utile lorsque l'utilisation de l'IA est strictement interdite, car un score d'IA de 0 % indique avec certitude une origine humaine. Cependant, cet outil est conçu pour minimiser les faux positifs, ce qui conduit parfois à surestimer le contenu généré par l'homme et entraîne certaines inexactitudes. Plus important encore, les rapports de signalement du détecteur n'indiquent pas précisément les parties d'un document qui sont générées par l'IA, notamment dans les textes hybrides, un format de plus en plus courant dans le milieu éducatif.

Contrairement à la détection de plagiat, le texte généré par l'IA n'a pas de source directe à laquelle se référer, de sorte que les sections signalées ne fournissent pas de références à la source originale. Ce manque de liens vérifiables limite la capacité des enseignants à confirmer de manière indépendante le contenu signalé, ce qui les oblige à faire confiance à l'algorithme de Turnitin sans preuve tangible.

Que disent les utilisateurs de Turnitin ?

Voyons maintenant comment les utilisateurs, et plus particulièrement les étudiants, perçoivent l'outil de détection d'IA de Turnitin. Si certains reconnaissent son intérêt potentiel, beaucoup expriment de sérieux doutes sur sa précision et son impartialité. Les discussions en ligne, notamment sur Reddit, témoignent d'une frustration grandissante face aux faux positifs et aux résultats incohérents. Les utilisateurs rapportent fréquemment que leurs travaux originaux, rédigés par des humains, sont incorrectement identifiés comme générés par l'IA.

Préoccupations des utilisateurs sur Reddit

Plusieurs utilisateurs de Reddit ont partagé leurs expériences personnelles, expliquant comment ils ont été injustement signalés par le détecteur d'IA de Turnitin :

Faux positifs : EyYoSup a signalé que son mémoire de fin d'études avait été identifié comme rédigé à 23 % par une IA, alors qu'il n'en avait absolument pas utilisé. Un autre utilisateur a été stupéfait de voir son texte, basé sur une analyse personnelle et des recherches provenant de sites web reconnus, obtenir un score de 48 % en détection d'IA.

Inexactitude reconnue par les établissements : Certains établissements semblent conscients de ces problèmes. Un commentateur a indiqué que son institution utilisait les résultats de la détection d'IA de Turnitin uniquement à titre indicatif, et non comme preuve définitive, reconnaissant qu'aucun détecteur d'IA actuel n'était fiable à 100 %.

Opinion

Ces témoignages d'utilisateurs révèlent un décalage entre les affirmations de Turnitin et la réalité vécue par les étudiants. Bien que l'outil puisse être performant dans certains cas, sa tendance à classer à tort des productions humaines authentiques – en particulier lorsque les étudiants paraphrasent ou synthétisent des recherches – soulève des questions d'équité. Une dépendance excessive à de tels outils pour la notation ou les décisions académiques, surtout sans transparence ni possibilité de recours, risque de pénaliser injustement des étudiants.

Pourquoi votre dissertation pourrait être considérée comme générée par l'IA

Beaucoup d'étudiants sont désorientés et frustrés quand Turnitin identifie leur travail original comme étant généré par l'IA. Si cela vous arrive, sachez que vous n'êtes pas seul.

Voici quelques raisons qui pourraient expliquer pourquoi votre dissertation, bien qu'écrite par vous, est tout de même signalée :

1. Un style trop formel ou générique

Les textes générés par l'IA ont souvent un ton soigné et neutre. Si votre dissertation utilise une grammaire impeccable, ne contient aucune contraction, ou ressemble à un manuel, l'outil de détection pourrait l'identifier à tort comme étant générée par l'IA, même si vous en êtes l'auteur.

2. Absence de voix personnelle ou de variété dans les phrases

Les outils d'IA ont tendance à produire des phrases aux structures prévisibles. Si votre style manque de diversité, de subtilité ou d'une voix personnelle distincte, il peut ressembler aux schémas produits par une machine.

3. Recours excessif à la paraphrase de sources en ligne

Même si vous faites des recherches approfondies et que vous paraphrasez tout par vous-même, résumer d'un peu trop près du contenu populaire en ligne peut imiter le style de l'IA, qui s'inspire également de données accessibles au public.

4. Dissertation trop courte ou nombre de mots insuffisant

Turnitin a indiqué que les dissertations de moins de 300 mots sont plus susceptibles d'être signalées par erreur. Les textes courts donnent moins de matière à l'outil de détection, ce qui augmente le risque d'une identification incorrecte.

5. Structure répétitive ou idées décousues

Un texte généré par l'IA peut parfois sembler répétitif ou excessivement logique, mais manquer de profondeur. Si votre travail contient des listes, des expressions répétées ou des transitions maladroites, il pourrait rappeler le style d'un texte généré par l'IA.

6. Sujets populaires ou fréquemment abordés

Les sujets largement débattus en ligne (comme le changement climatique, les avantages des réseaux sociaux ou les uniformes scolaires) sont bien connus des modèles d'IA. Si votre argumentation suit des schémas habituels ou reprend des expressions courantes, l'outil de détection peut l'identifier comme étant écrit par l'IA.

7. Style de citation et de référence

Dans certains cas, l'outil de détection de Turnitin peut signaler certains styles de citation ou certaines listes de références qui ressemblent fortement aux données d'apprentissage de l'IA. Cela reste rare, mais cela peut arriver, surtout si vos sources sont très utilisées ou formulées de manière générique.

Pour les étudiants : Que faire si le détecteur d'IA de Turnitin vous signale

Être identifié comme ayant potentiellement utilisé l'IA alors que ce n'est pas le cas peut être frustrant et injuste. Mais pas de panique : vous pouvez prendre des mesures pour expliquer et défendre votre travail.

1. Restez calme et analysez le rapport

Commencez par examiner attentivement la note dans le rapport Turnitin. Turnitin n'affirme pas que votre document a été entièrement rédigé par une IA ; il fournit un pourcentage d'éléments qu'il suspecte d'avoir été générés par une IA. Identifiez les passages signalés et demandez-vous : certains passages semblent-ils trop léchés, répétitifs ou similaires à ce que produit généralement une IA ?

2. Rassemblez des preuves de votre méthode de rédaction

La meilleure façon de prouver l'originalité de votre travail est de montrer comment vous l'avez créé :

Montrez vos brouillons – Si vous avez rédigé votre essai dans Google Docs ou Word, utilisez la fonction historique des versions ou le suivi des modifications pour justifier votre méthode de travail.

Prenez des captures d'écran ou des vidéos – Fournir des notes manuscrites, des plans ou des recherches imprimées avec des annotations peut appuyer votre démarche.

Fournissez vos références – Si vous avez utilisé des sources externes, communiquez-les à votre enseignant en expliquant comment vous avez utilisé ces informations.

3. Discutez avec votre enseignant

Contactez votre enseignant avec respect. Expliquez que ce travail est le vôtre et fournissez des éléments de preuve de votre processus de rédaction. Indiquez que vous êtes disposé à lui expliquer comment vous avez développé vos idées. La plupart des enseignants apprécient la transparence et les efforts, plus que la confrontation.

4. Demandez une nouvelle évaluation

Si votre établissement le permet, vous pouvez demander un deuxième avis ou faire appel. N'hésitez pas à demander des précisions sur le règlement et sur vos droits en tant qu'étudiant.

Comment les enseignants doivent-ils utiliser les rapports de détection d'IA de Turnitin ?

Les enseignants doivent aborder les rapports de détection d'IA de Turnitin avec prudence, contexte et communication : non pas comme un verdict définitif, mais comme un élément d'information contribuant à une vision globale du contexte académique. Voici comment utiliser ces outils de manière responsable et équitable :

1. Ne vous fiez pas uniquement au score

Le score d'IA de Turnitin n'est pas une preuve de fraude. Il est destiné à soutenir, et non à remplacer, le jugement d'un enseignant. Un pourcentage élevé ne signifie pas automatiquement que l'étudiant a triché.

2. Comparez avec les travaux antérieurs

Examinez le devoir signalé en parallèle avec les travaux soumis précédemment par l'étudiant. Existe-t-il des différences de ton, de structure, de vocabulaire ou de complexité ? Des changements soudains peuvent soulever des questions légitimes, mais uniquement s'ils sont considérés dans leur contexte.

3. Vérifiez avec d'autres outils

Analyser le même texte à l'aide de différents détecteurs d'IA peut fournir des informations supplémentaires. Les résultats peuvent varier, mais si plusieurs outils soulèvent les mêmes préoccupations, un examen plus approfondi peut être justifié.

4. Discutez avec l'étudiant

Ayez une conversation respectueuse. Interrogez-le sur son processus d'écriture, ses sources et son échéancier. Montrez-lui les sections signalées. S'il peut fournir des brouillons, des notes ou un historique des versions (par exemple, dans Google Docs), cela apporte un éclairage précieux.

5. Offrez une possibilité de révision

À moins qu'il n'y ait une preuve manifeste d'utilisation abusive intentionnelle, il est souvent préférable de donner aux étudiants la possibilité de réviser ou de reformuler leur travail. De nombreux étudiants n'ont peut-être pas conscience de la manière dont leur style d'écriture pourrait être mal interprété par un algorithme.

6. Suivez la politique de l'établissement

Si vous pensez qu'une faute a été commise et que l'étudiant ne fournit pas d'explication raisonnable, suivez la procédure d'intégrité académique de votre établissement, tout en gardant à l'esprit les limites des outils de détection de l'IA et le risque de faux positifs.

7. Soyez proactif quant aux attentes

Établissez des règles claires au début du cours concernant l'utilisation de l'IA : ce qui est autorisé, ce qui ne l'est pas et comment citer les outils tels que ChatGPT si leur utilisation est permise. Le fait de définir ces attentes dès le départ évite toute confusion et favorise la confiance.

FAQ

Q : Turnitin peut-il se tromper ?

R : Oui, Turnitin peut faire des erreurs. Ses outils de détection de plagiat et d'IA sont utiles, mais ils ne sont pas parfaits. Parfois, un travail original est signalé incorrectement, surtout s'il ressemble à des modèles d'écriture courants ou à des informations fortement citées.

Q : Est-ce qu'un score de 36 % sur Turnitin est acceptable ?

R : Cela dépend de la tâche. Pour la détection de plagiat, un score de 36 % sur Turnitin pourrait être acceptable si la plupart provient de citations ou de références correctement citées. Pour la détection de l'IA, c'est plus compliqué : 30 % peuvent être préoccupants, selon ce qui a été signalé et comment l'instructeur l'interprète.

Q : Turnitin est-il vraiment fiable ?

R : Turnitin est un outil largement utilisé, mais il n'est pas infaillible. Il est plus efficace pour détecter les correspondances textuelles directes pour le plagiat, et la détection de l'IA, plus récente, continue d'être améliorée. Il est conseillé aux éducateurs de l'utiliser comme guide, et non comme un jugement final.

Q : Un score de 70 % sur Turnitin est-il mauvais ?

R : Un score de similarité de 70 % pour le plagiat doit alerter et nécessite un examen attentif. Pour la détection de l'IA, un score de 70 % ne signifie pas automatiquement une faute, mais incitera probablement votre instructeur à enquêter davantage.

Q : Quelle est la précision du détecteur d'IA de Turnitin ?

R : Il est raisonnablement précis avec des textes clairement écrits par l'IA ou par des humains, mais il rencontre des difficultés avec l'écriture hybride, où les contributions humaines et de l'IA sont mélangées. La précision diminue encore lorsque le contenu de l'IA est paraphrasé ou fortement modifié.

Q : Quelle est la précision du détecteur d'IA de Turnitin par rapport aux autres ?

R : Selon des études indépendantes, Turnitin fonctionne mieux que de nombreux détecteurs gratuits, mais il n'est toujours pas parfait. Dans les cas mixtes ou paraphrasés, sa précision peut tomber en dessous de 50 %. D'autres outils comme GPTZero ou Originality.ai peuvent offrir des résultats différents, mais ont également des limites.

Q : Turnitin peut-il détecter l'IA sous 300 mots ?

R : Pas de manière fiable. Les réponses courtes ne fournissent pas suffisamment de contexte pour que le détecteur d'IA de Turnitin prenne une décision ferme. Dans ces cas, le risque de faux positifs augmente.

Conclusion

Le détecteur d'IA de Turnitin n'est pas toujours précis, et le fait d'être identifié comme contenu potentiellement généré par IA ne signifie pas automatiquement une faute. Ces outils sont encore en développement et peuvent identifier à tort l'écriture humaine, surtout lorsqu'elle ressemble aux schémas fréquemment observés dans les contenus créés par l'IA.

Il est donc important que les étudiants et les enseignants examinent les résultats de la détection de l'IA avec prudence, en tenant compte du contexte, et dans un esprit de dialogue. En comprenant le fonctionnement de ces outils et les raisons des faux positifs, nous pourrons adopter une utilisation plus juste, éclairée et réfléchie de l'IA dans le domaine de l'éducation.