Ist Turnitins KI-Prüfer präzise? Echte Fälle & Blicke

Du hast einen Aufsatz eingereicht, den du ganz allein geschrieben hast—keine AI, keine Abkürzungen. Aber dann markiert Turnitin ihn als AI-generiert. Jetzt fragst du dich: Wie genau ist dieses Erkennungssystem eigentlich? Du bist nicht allein mit dieser Frage.

In diesem Artikel erklären wir, was Turnitins AI-Erkennungstool ist, wie es funktioniert und – was am wichtigsten ist – welche Faktoren dazu führen könnten, dass deine Arbeit markiert wird. Außerdem gehen wir darauf ein, was echte Daten und Erfahrungen über die Zuverlässigkeit aussagen.

Tauchen wir ein und entdecken, was wirklich hinter Turnitins AI-Ergebnissen steckt.

Ist Turnitins KI-Detektor zuverlässig? – Was die offiziellen Daten belegen

Turnitin führte im Jahr 2023 offiziell seine Technologie zur Erkennung von KI-gestütztem Schreiben ein, um Inhalte zu identifizieren, die entweder von KI-Tools wie ChatGPT erstellt oder umformuliert wurden. Ziel ist es, die akademische Integrität zu unterstützen und gleichzeitig das Risiko ungerechtfertigter Anschuldigungen gegen Studierende zu minimieren. Um die tatsächliche Genauigkeit dieses Systems zu verstehen, können wir die öffentlich zugänglichen Daten und Entscheidungen von Turnitin betrachten.

Wie Turnitins KI-Detektor funktioniert

Turnitins Indikator für KI-gestütztes Schreiben analysiert den Text einer Einsendung und bewertet einzelne Abschnitte danach, wie wahrscheinlich es ist, dass sie von einer KI generiert wurden. Dabei vergleicht er statistische Muster in der Wortwahl, Satzstruktur und Ausdrucksweise mit dem typischen Schreibverhalten großer Sprachmodelle (LLMs) wie GPT-3 und GPT-4. Da KI-generierte Texte tendenziell regelmäßigeren Wortmustern folgen als menschliche Texte, ermittelt das System, wie stark jeder Abschnitt den typischen KI-Mustern ähnelt.

Sobald das Tool Inhalte als von KI generiert kennzeichnet, wird eine zweite Überprüfung durchgeführt, um festzustellen, ob diese Inhalte mithilfe von KI-Tools (z. B. QuillBot) paraphrasiert wurden. Dieser zweistufige Prozess ermöglicht es, sowohl direkt von KI verfasste Texte als auch umformulierte KI-Inhalte zu erkennen.

Was Turnitin zur Genauigkeit mitteilt

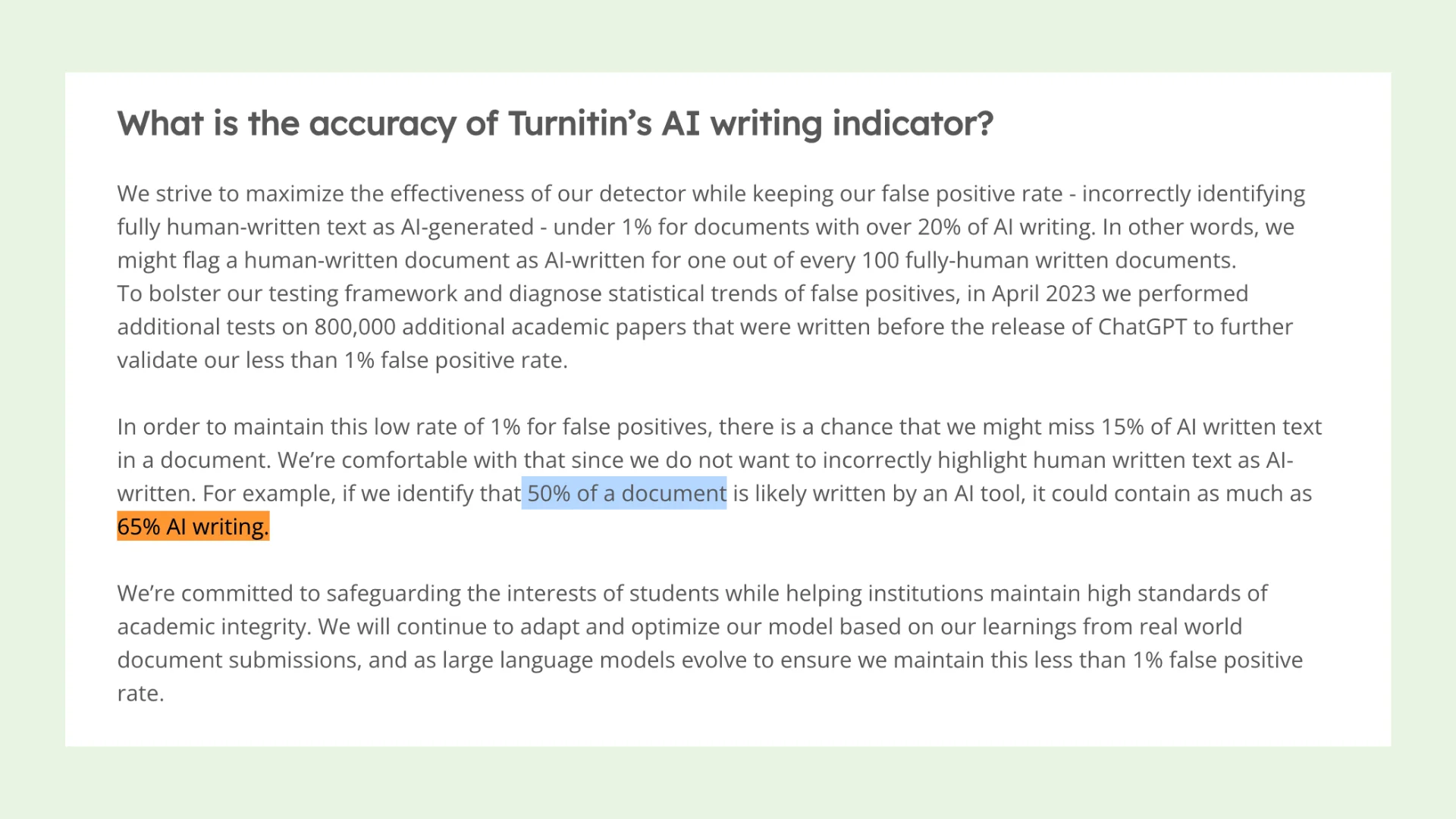

Den eigene Angaben von Turnitin zufolge wurde das System so konzipiert, dass es bei Dokumenten mit über 20% KI-gestütztem Schreiben eine Fehlalarmrate von unter 1% aufweist. Das bedeutet, dass von 100 menschlich verfassten Arbeiten weniger als eine fälschlicherweise als KI-generiert markiert wird. Um diesen Anspruch zu untermauern, testete Turnitin sein System an 800.000 wissenschaftlichen Arbeiten, die vor der Einführung von ChatGPT entstanden, und nutzte diese als Referenz für authentisch menschliches Schreiben.

Um die Fehlalarmrate niedrig zu halten, akzeptiert Turnitin dabei allerdings einen Kompromiss: Es könnte etwa 15% der KI-generierten Inhalte übersehen. Zum Beispiel könnte der tatsächliche Anteil an KI-generierten Inhalten bei einem Dokument, das laut Turnitin zu 50% von KI stammt, näher bei 65% liegen. Dies verdeutlicht den vorsichtigen Ansatz des Systems – es vermeidet lieber fälschliche Anschuldigungen bei echten, menschlich verfassten Texten.

(Quelle: Turnitin)

Aktuelle Anpassungen zur Verbesserung der Genauigkeit

Um die Leistung des Systems zu steigern und Fehler zu minimieren, hat Turnitin basierend auf internen Tests mehrere Updates implementiert:

Asterisk-Warnungen bei niedrigen KI-Werten: KI-Werte unter 20% werden nun im Bericht mit einem Asterisk versehen, was darauf hinweist, dass diese Ergebnisse weniger zuverlässig sind und eine höhere Wahrscheinlichkeit für Fehlalarme besteht.

Erhöhung der Mindestwortzahl: Die Grenze für die automatische KI-Erkennung wurde von 150 auf 300 Wörter angehoben. Turnitin stellte fest, dass längere Texte zu präziseren Ergebnissen führen.

Anpassungen bei der Erkennung von Einleitungen und Schlussfolgerungen: Da Fehlalarme häufig zu Beginn oder am Ende von Arbeiten (z. B. in Einleitungen oder Schlussfolgerungen) auftreten, wurde die Analyse dieser Bereiche überarbeitet.

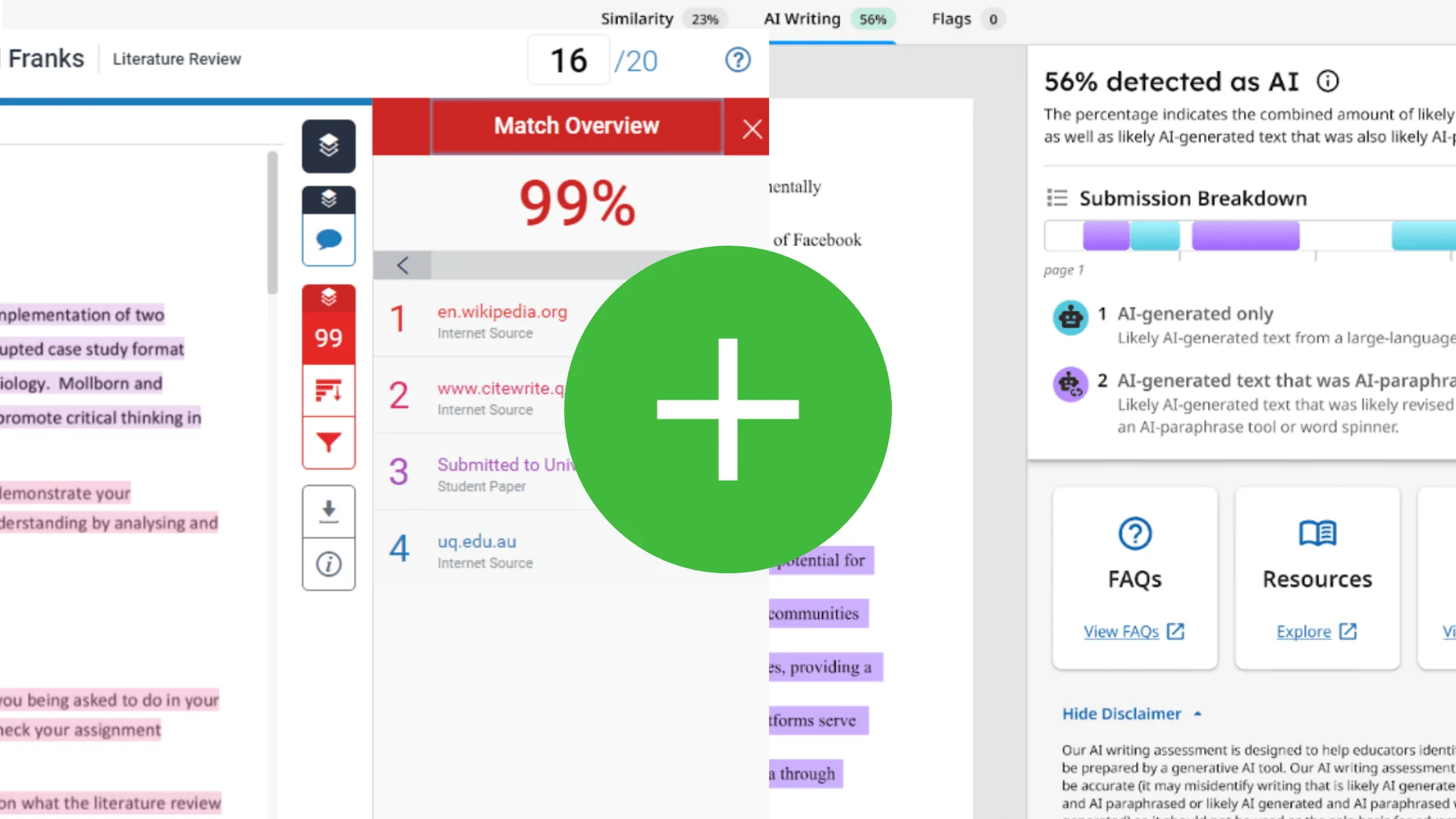

Erkennung von KI-Paraphrasierungen

Turnitin bietet zudem ein Tool zur Erkennung von KI-paraphrasierten Texten an, das jedoch erst aktiviert wird, nachdem Inhalte als KI-generiert eingestuft wurden. Dadurch wirkt sich die Überprüfung der Paraphrasierung nicht auf die gesamte Fehlalarmrate aus. Dennoch kann der Paraphrasierungsdetektor manchmal fälschlicherweise den Umfang der KI-Beteiligung falsch interpretieren:

Er könnte KI-generierte Texte gleichzeitig als KI-generiert und als KI-paraphrasiert einstufen (selbst wenn keine Paraphrasierung stattgefunden hat), oder

Er könnte übersehen, dass bestimmte KI-generierte Texte auch paraphrasiert wurden.

Ist Turnitins KI-Detektor voreingenommen gegenüber nicht-muttersprachlichen Englischschreibern?

Von Liang et al. (2023) geäußerte Bedenken:

Im Jahr 2023 äußerten die Forscher Liang und Kollegen Bedenken, dass KI-Schreiberkennungssysteme voreingenommen gegenüber nicht-muttersprachlichen Englischschreibern sein könnten – auch bekannt als Autoren, die Englisch als Zweitsprache lernen (ELL). Ihre Ergebnisse basierten auf der Analyse von 91 TOEFL-Praxisaufsätzen, die jeweils weniger als 150 Wörter umfassten. Die Studie löste in der akademischen Gemeinschaft breite Diskussionen aus und veranlasste einige Turnitin-Nutzer, eine detailliertere Stellungnahme des Unternehmens zu fordern.

Liang, W., Yuksekgonul, M., Mao, Y., Wu, E., & Zou, J. (2023). GPT-Detektoren sind voreingenommen gegenüber nicht-muttersprachlichen Englischschreibern. arXiv Preprint arXiv:2304.02819.

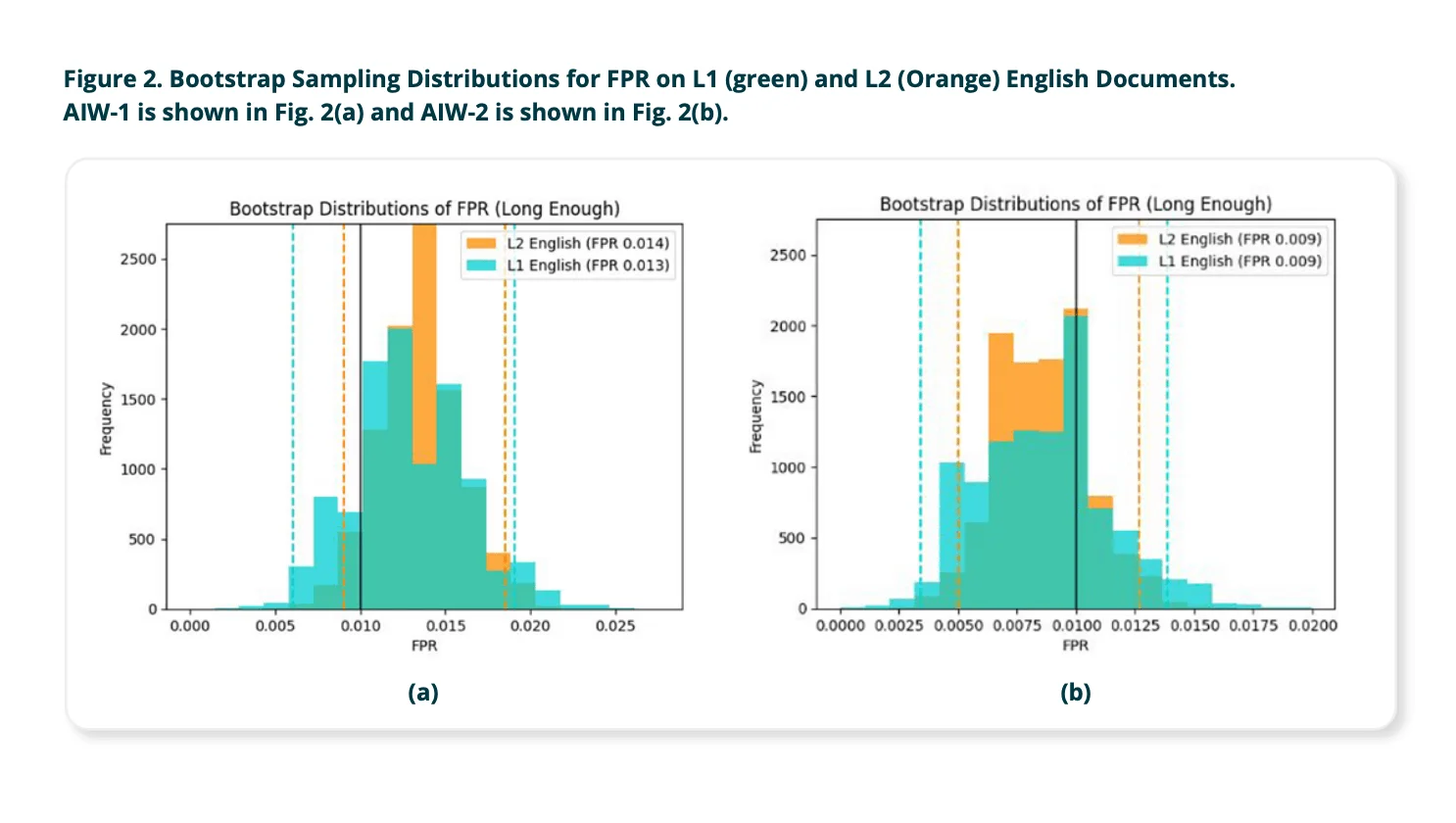

Als Reaktion veröffentlichte Turnitin im Oktober 2023 eine eigene Studie, um zu prüfen, ob sein KI-Schreibdetektor eine statistisch signifikante Voreingenommenheit gegenüber ELL-Autoren aufweist.

Was stellte Turnitin fest?

Turnitin testete seinen KI-Schreibdetektor mit tausenden authentischen Studentenaufsätzen, die aus verschiedenen offenen akademischen Datensätzen stammten. Dabei wurden Texte sowohl von Muttersprachlern im Englischen (L1-Schreibern) als auch von ELL-Autoren (L2-Schreibern) berücksichtigt. Die Texte wurden anhand ihrer Länge kategorisiert:

Kurze Texte: 150–300 Wörter

Längere Texte: 300 Wörter oder mehr

Dies waren ihre Erkenntnisse:

Für längere Texte (300 Wörter oder mehr):

Die Fehlalarmrate – also die Wahrscheinlichkeit, dass der Detektor fälschlicherweise menschlich verfasste Texte als KI-generiert einstuft – war nahezu identisch bei ELL- und muttersprachlichen Englischschreibern. Der Unterschied war so gering, dass er statistisch nicht signifikant war.

➡️ Schlussfolgerung: Erfüllen die Dokumente die Mindestwortzahl, zeigt Turnitins KI-Detektor keine messbare Voreingenommenheit gegenüber ELL-Autoren.

Für kürzere Texte (unter 300 Wörter):

Die Fehlalarmrate stieg insgesamt an, und der Unterschied zwischen muttersprachlichen und nicht-muttersprachlichen Autoren wurde deutlich. Turnitin räumte ein, dass kürzere Texte nicht genügend sprachliche Informationen („Signal“) enthalten, damit das KI-Modell zuverlässig zwischen menschlichem und KI-generiertem Text unterscheiden kann.

➡️ Dadurch wird der Detektor für alle kurzen Einreichungen weniger zuverlässig – und potenziell insbesondere für ELL-Autoren.

Infolgedessen hat Turnitin sein System dahingehend aktualisiert, dass nur Beiträge mit mindestens 300 Wörtern bewertet werden, um Fehlalarme zu reduzieren und die Genauigkeit zu verbessern.

Abschließende Schlussfolgerung:

Turnitin kommt zu dem Schluss, dass sein KI-Schreibdetektor keine Voreingenommenheit gegenüber nicht-muttersprachlichen Englischschreibern aufweist, solange der Beitrag die Mindestwortzahl von 300 Wörtern erfüllt. Zudem hob das Unternehmen seine kontinuierlichen Bemühungen hervor, die Fairness und Zuverlässigkeit des Systems zu verbessern – insbesondere vor dem Hintergrund, dass sich große Sprachmodelle (LLMs) stetig weiterentwickeln.

Wie reagieren die Universitäten?

Während Turnitin die Integrität seines KI-Schreibdetektors verteidigt, bleiben einige akademische Institutionen skeptisch. Mehrere Universitäten haben Sorgen bezüglich der Transparenz, Zuverlässigkeit und der potenziellen Auswirkungen auf das Vertrauen der Studierenden geäußert. Einige haben sich sogar entschieden, die Funktion vollständig abzuschalten, da sie Risiken durch falsche Anschuldigungen und unzureichende Validierung befürchten. Im Folgenden werden Beispiele gezeigt, wie zwei US-amerikanische Universitäten – Vanderbilt Universität und Temple Universität – Turnitins KI-Erkennungssystem bewertet und darauf reagiert haben.

Entscheidung der Vanderbilt Universität, Turnitins KI-Detektor abzuschalten

Die Vanderbilt Universität entschied sich, Turnitins KI-Erkennung aufgrund von Zweifeln an der Effektivität und Transparenz des Systems abzuschalten. Das Tool wurde den Kunden mit weniger als 24 Stunden Vorlaufzeit aktiviert, ohne dass eine Option zum Abmelden bestand. Vanderbilt stellte in Frage, wie der Detektor arbeitet, da Turnitin keine detaillierten Methoden zur Identifizierung von KI-generierten Texten offenlegte. Obwohl Turnitin von einer Falsch-Positiv-Rate von 1% spricht, wies Vanderbilt darauf hin, dass dies bei 75.000 im Jahr 2022 eingereichten Arbeiten rund 750 falsch positive Hinweise auf den Einsatz von KI bedeuten könnte. Auch andere Universitäten berichteten von Fällen, in denen Studierende fälschlicherweise der KI-Nutzung beschuldigt wurden – oft im Zusammenhang mit Turnitins Detektor. Darüber hinaus deuten Studien darauf hin, dass der Detektor besonders häufig Texte von Nicht-Muttersprachlern des Englischen als KI-generiert markiert, was zu Fairnessbedenken führt.

Bewertung von Turnitins KI-Schreibdetektor an der Temple Universität

Forscher des Zentrums für Studierendenerfolg und des Zentrums für die Förderung des Lehrens der Temple Universität (Temple CAT) führten eine Studie zu Turnitin durch und analysierten 120 Textproben, die in vier Kategorien eingeteilt wurden: vollständig von Menschen verfasste, vollständig KI-generierte, getarnte KI-generierte (bei denen Texte umformuliert wurden, um der Erkennung zu entgehen) sowie hybride Texte, die Beiträge sowohl von KI als auch von Menschen enthalten. Diese hybriden Texte spiegelten reale sowie bildungsbezogene Szenarien wider – von KI-generierten Inhalten, die von Menschen überarbeitet wurden, bis hin zu von Menschen verfassten Texten, die von KI optimiert wurden. Alle Proben wurden mit Turnitins KI-Detektor untersucht.

Ergebnisse:

Von Menschen verfasste Texte: 93% korrekt identifiziert.

Vollständig KI-generierte Texte: 77% korrekt erkannt.

Getarnte KI-generierte Texte: Die Erkennungsrate sank auf 63%.

Hybride Texte: Nur 43% wurden korrekt identifiziert; die Markierungen des Detektors passten schlecht zu den tatsächlich KI-generierten Textabschnitten.

Insgesamt erzielte Turnitins KI-Detektor eine Genauigkeit von rund 86% bei der Erkennung von KI-Nutzung, wies jedoch eine Fehlerquote von 14% auf – insbesondere bei getarnten und hybriden Texten.

Diskussion und Implikationen:

Turnitins KI-Detektor erkennt rein menschlich verfasste Arbeiten zuverlässig und ist besonders nützlich, wenn die Nutzung von KI strikt verboten ist, denn ein 0%-Ergebnis weist stark auf menschliche Urheberschaft hin. Gleichzeitig ist das System darauf ausgelegt, falsch-positive Ergebnisse zu minimieren, was manchmal dazu führt, dass menschliche Beiträge überbewertet werden und Ungenauigkeiten auftreten. Entscheidend ist, dass die Berichte des Detektors nicht exakt aufschlüsseln, welche Teile eines Textes von KI generiert wurden – ein Format, das in Bildungseinrichtungen immer häufiger vorkommt.

Anders als bei der Plagiaterkennung besitzt KI-generierter Text keine eindeutige Quelle, auf die verwiesen werden kann. Daher liefern markierte Abschnitte keine Originalquellenangaben. Dieses Fehlen überprüfbarer Links erschwert es Dozenten, die beanstandeten Inhalte eigenständig zu verifizieren, und setzt ein Vertrauen in Turnitins Algorithmus voraus, ohne dass transparente Nachweise erbracht werden.

Was sagen gewöhnliche Nutzer über Turnitin?

Werfen wir nun einen Blick darauf, wie alltägliche Anwender – vor allem Studierende – auf Turnitin’s KI-Detektor reagieren. Zwar wird das Potenzial des Tools von einigen anerkannt, doch äußern viele ernste Zweifel hinsichtlich seiner Genauigkeit und Fairness. Diskussionen im Internet, speziell auf Plattformen wie Reddit, zeigen eine zunehmende Frustration über falsche Treffer und uneinheitliche Ergebnisse. Häufig berichten Nutzer, dass ihre originären, von Menschen verfassten Arbeiten fälschlicherweise als KI-generiert markiert werden.

Benutzerbedenken auf Reddit

Mehrere Reddit-Nutzer haben persönliche Erfahrungen geteilt, in denen sie vom KI-Detektor von Turnitin ungerecht beschuldigt wurden:

Falsche Treffer: EyYoSup berichtete, dass ihre Abschlussarbeit zu 23% als KI-generiert eingestuft wurde, obwohl überhaupt keine KI zum Einsatz kam. Ein anderer Nutzer war schockiert, einen Wert von 48% zu erhalten, obwohl der Inhalt ausschließlich auf persönlicher Analyse und auf Recherchen von renommierten Websites basierte.

Von Schulen anerkannte Ungenauigkeiten: Einige Bildungseinrichtungen erkennen diese Probleme an. Ein Kommentator erwähnte, dass seine Institution die Ergebnisse der Turnitin-KI-Erkennung nur als Referenz verwendet und nicht als endgültigen Beweis heranzieht, da man anerkenne, dass kein derzeitiger KI-Detektor zu 100% zuverlässig sei.

Meinung

Die Berichte der Nutzer deuten auf eine Lücke zwischen Turnitin’s Versprechen und den tatsächlichen Erfahrungen der Studierenden hin. Obwohl das Tool unter bestimmten Bedingungen gut funktionieren kann, führt seine Neigung, authentisch menschliches Schreiben – besonders dann, wenn Studierende Forschung in eigenen Worten wiedergeben oder zusammenfassen – fehlzuinterpretieren, zu berechtigten Fairness-Bedenken. Eine zu starke Abhängigkeit von solchen Werkzeugen bei der Bewertung oder bei akademischen Entscheidungen, insbesondere ohne transparente Verfahren oder die Möglichkeit einer Beschwerde, birgt das Risiko, Studierenden zu schaden, die nichts falsch gemacht haben.

Warum Ihr Aufsatz möglicherweise als KI erkannt wird

Viele Studierende fühlen sich verwirrt und frustriert, wenn Turnitin ihre ursprüngliche Arbeit als KI-generiert einstuft. Falls Ihnen das passiert ist, sind Sie keinesfalls allein.

Im Folgenden finden Sie einige spezifische Gründe, warum Ihr von Menschen verfasster Aufsatz trotzdem als KI-Erzeugnis identifiziert werden könnte:

1. Übermäßig formelle oder generische Sprache

KI-generierte Texte klingen oft sehr poliert und neutral. Wenn Ihr Aufsatz perfekte Grammatik, keine Kontraktionen verwendet oder wie ein Lehrbuch wirkt, könnte der Detektor ihn fälschlicherweise als von KI erstellt interpretieren – selbst wenn Sie ihn selbst verfasst haben.

2. Mangel an persönlicher Note oder Satzvariation

KI-Tools neigen dazu, Sätze mit vorhersehbaren Strukturen zu produzieren. Fehlen in Ihrem Schreibstil Variationen, Nuancen oder eine erkennbare persönliche Note, kann dies maschinenähnliche Muster hervorrufen.

3. Starkes Paraphrasieren von Online-Quellen

Auch wenn Sie gründlich recherchieren und alles selbst umformulieren, kann ein zu nahes Zusammenfassen von populären Online-Inhalten den Stil von KI imitieren, da diese ebenfalls auf öffentlich verfügbare Daten zurückgreift.

4. Kurze Länge oder geringe Wortzahl

Turnitin hat erklärt, dass Aufsätze mit weniger als 300 Wörtern häufiger fälschlicherweise identifiziert werden. Kürzere Texte bieten dem KI-Detektor weniger Kontext, was das Risiko einer Fehlidentifikation erhöht.

5. Wiederholende Struktur oder lose verbundene Ideen

KI-generiertes Schreiben kann manchmal repetitiv oder übermäßig logisch wirken, aber es fehlt oft an Tiefe. Enthält Ihre Arbeit Listen, wiederholte Formulierungen oder schwache Übergänge, könnte sie den typischen Fluss von KI-Texten nachahmen.

6. Populäre oder häufig diskutierte Themen

Themen, die online breit diskutiert werden – wie der Klimawandel, die Vorteile sozialer Medien oder Schuluniformen – sind KI-Modellen vertraut. Wenn Ihr Argument gängige Muster aufweist oder bekannte Formulierungen benutzt, könnte der Detektor es als von KI erzeugt einstufen.

7. Zitier- und Referenzstil

Manchmal kann auch der von Turnitin verwendete Detektor bestimmte Zitierstile oder Literaturverzeichnisse als verdächtig markieren, wenn sie stark an den KI-Trainingsdaten orientiert sind. Dies ist zwar selten, kann aber insbesondere dann der Fall sein, wenn Ihre Quellen weit verbreitet oder generisch formuliert sind.

Für Studierende: Was tun, wenn Sie vom AI Detector von Turnitin markiert werden

Es kann frustrierend und unfair sein, als KI-Nutzer markiert zu werden, obwohl Sie tatsächlich keine KI verwendet haben. Aber bewahren Sie Ruhe—es gibt Maßnahmen, die Ihnen helfen, Ihre Arbeit zu erklären und zu verteidigen.

1. Bleiben Sie ruhig und prüfen Sie den Bericht

Überprüfe zuerst sorgfältig die Punktzahl im Turnitin-Bericht. Turnitin kennzeichnet Ihre Arbeit nicht als eindeutig von KI verfasst, sondern gibt einen Prozentsatz an, wie viel es vermutet, dass von KI generiert wurde. Sehen Sie sich an, welche Abschnitte markiert wurden, und fragen Sie sich: Wirkte irgendetwas zu ausgefeilt, zu wiederholend oder zu ähnlich wie typische KI-Ausgaben?

2. Sammeln Sie Nachweise für Ihren Schreibprozess

Der beste Weg, um zu belegen, dass Ihre Arbeit eigenständig ist, besteht darin, zu zeigen, wie Sie sie erstellt haben:

Zeigen Sie Ihre Entwürfe – Wenn Sie Ihren Aufsatz in Google Docs oder Word verfasst haben, nutzen Sie die Funktionen Version History oder Track Changes, um Ihren Schreibprozess zu dokumentieren.

Machen Sie Screenshots oder Videos – Dokumentieren Sie Ihre handschriftlichen Notizen, Gliederungen oder gedruckte Recherchen mit Markierungen, um Ihren Standpunkt zu untermauern.

Reichen Sie Ihre Quellen ein – Falls Sie externe Quellen verwendet haben, legen Sie diese Ihrem Dozenten zusammen mit Erläuterungen bei, wie Sie die Informationen verarbeitet haben.

3. Sprechen Sie mit Ihrem Dozenten

Nehmen Sie respektvoll Kontakt auf. Erklären Sie, dass der Inhalt von Ihnen stammt, und legen Sie die Beweise Ihres Schreibprozesses vor. Signalisieren Sie, dass Sie gerne erläutern, wie Sie Ihre Ideen entwickelt haben. Die meisten Dozenten schätzen Offenheit und Einsatz mehr als Konfrontation.

4. Bitten Sie um Überprüfung oder Neubewertung

Falls es die Richtlinien Ihrer Schule erlauben, können Sie um eine zweite Meinung oder einen akademischen Einspruch bitten. Zögern Sie nicht, um Klarheit bezüglich der Richtlinien und Ihrer Rechte als Studierender zu bitten.

Wie sollten Lehrer Turnitins AI-Erkennungsberichte nutzen?

Lehrer sollten Turnitins AI-Erkennungsberichte mit Vorsicht, im richtigen Kontext und in offener Kommunikation betrachten – nicht als endgültiges Urteil, sondern als einen Baustein in einem umfassenderen akademischen Gesamtbild. Im Folgenden wird erläutert, wie diese Werkzeuge verantwortungsvoll und fair eingesetzt werden können:

1. Verlasse dich nicht allein auf das Ergebnis

Die AI-Bewertung von Turnitin ist kein Beweis für Fehlverhalten. Sie soll unterstützen und nicht das Urteil des Lehrers ersetzen. Ein hoher Anteil bedeutet nicht zwangsläufig, dass der Schüler betrogen hat.

2. Vergleiche mit früheren Arbeiten

Vergleiche die markierte Aufgabe mit den bisherigen Einreichungen des Schülers. Gibt es Unterschiede im Ton, in der Struktur, im Wortschatz oder in der Komplexität? Plötzliche Veränderungen können berechtigte Fragen aufwerfen – allerdings nur im jeweiligen Kontext.

3. Nutze auch andere Prüfwerkzeuge

Wenn du denselben Text mit verschiedenen AI-Erkennungstools überprüfst, bekommst du zusätzliche Einblicke. Die Ergebnisse können variieren, aber wenn mehrere Werkzeuge dieselben Bedenken äußern, ist eine detailliertere Überprüfung ratsam.

4. Führe ein Gespräch mit dem Schüler

Suche das Gespräch auf respektvolle Weise. Frage nach dem Schreibprozess, den verwendeten Quellen und dem Zeitplan. Zeige dem Schüler die markierten Abschnitte. Wenn er Entwürfe, Notizen oder eine Versionshistorie (z. B. in Google Docs) vorlegen kann, liefert das wichtigen Kontext.

5. Gib die Möglichkeit zur Überarbeitung

Sofern es keine eindeutigen Anzeichen für absichtlichen Missbrauch gibt, ist es oft besser, den Schülern die Chance zu geben, ihren Text zu überarbeiten oder neu zu verfassen. Viele Schüler sind sich nicht bewusst, wie ihr Schreiben von einem Algorithmus fehlinterpretiert werden könnte.

6. Halte dich an institutionelle Richtlinien

Falls du den Verdacht hast, dass Fehlverhalten vorliegt und der Schüler keine stichhaltige Erklärung liefert, solltest du dem akademischen Integritätsprozess deiner Schule folgen – jedoch immer die Grenzen der AI-Erkennungswerkzeuge und die Möglichkeit von Fehlalarmen berücksichtigen.

7. Kommuniziere die Erwartungen von Anfang an

Setze zu Beginn des Kurses klare Regeln für den Einsatz von AI: Was erlaubt ist, was nicht, und wie Werkzeuge wie ChatGPT (falls zugelassen) zitiert werden sollen. Klare Erwartungen von Anfang an vermeiden Missverständnisse und fördern das Vertrauen.

Häufig gestellte Fragen

Q: Ist es möglich, dass Turnitin sich irrt?

A: Ja, Turnitin kann Fehler machen. Seine Werkzeuge zur Plagiatserkennung und KI-Erkennung sind nützlich, aber sie sind nicht perfekt. Manchmal wird Originalarbeit fälschlicherweise markiert, insbesondere wenn sie gängigen Schreibmustern oder stark zitierten Informationen ähnelt.

Q: Sind 36% bei Turnitin in Ordnung?

A: Das hängt von der Aufgabe ab. Bei der Plagiatserkennung könnte ein Turnitin-Score von 36% akzeptabel sein, wenn der Großteil aus korrekt zitierten Quellen oder Zitaten stammt. Bei der KI-Erkennung ist es komplizierter – 30% können, je nachdem was markiert wurde und wie der Dozent es interpretiert, bedenklich sein oder auch nicht.

Q: Ist Turnitin wirklich zuverlässig?

A: Turnitin ist ein weit verbreitetes Tool, aber es ist nicht unfehlbar. Es ist besonders effektiv beim Erkennen direkter Textübereinstimmungen zur Plagiatserkennung, während die KI-Erkennung noch relativ neu ist und weiter verbessert wird. Lehrkräfte wird empfohlen, es als Hilfsmittel zu betrachten – nicht als abschließendes Urteil.

Q: Sind 70% bei Turnitin problematisch?

A: Ein Ähnlichkeitswert von 70% bei der Plagiatserkennung gibt in der Regel Anlass zur Sorge und erfordert eine genaue Überprüfung. Bei der KI-Erkennung bedeutet ein Wert von 70% nicht automatisch Fehlverhalten, führt jedoch meist dazu, dass der Dozent weiter nachforscht.

Q: Wie präzise ist der Turnitin KI-Detektor?

A: Er ist relativ genau bei klar als KI oder Menschen verfassten Texten, hat jedoch Schwierigkeiten, wenn Schreibstile vermischt werden – also wenn menschliche und KI-Beiträge kombiniert sind. Die Genauigkeit nimmt weiter ab, wenn KI-Inhalte umformuliert oder stark bearbeitet werden.

Q: Wie genau schneidet der Turnitin KI-Detektor im Vergleich zu anderen ab?

A: Unabhängige Studien zeigen, dass Turnitin besser abschneidet als viele kostenlose Detektoren, auch wenn es nicht perfekt ist. In Fällen, in denen Texte gemischt oder paraphrasiert wurden, kann die Genauigkeit auf unter 50% sinken. Andere Tools wie GPTZero oder Originality.ai liefern möglicherweise abweichende Ergebnisse, haben jedoch ebenfalls ihre Einschränkungen.

Q: Kann Turnitin KI in Texten mit weniger als 300 Wörtern erkennen?

A: Nicht zuverlässig. Kurze Antworten bieten nicht genügend Kontext, damit der KI-Detektor von Turnitin eine fundierte Einschätzung treffen kann. In solchen Fällen steigt das Risiko von Fehlalarmen.

Abschließende Gedanken

Turnitins AI-Detektor ist nicht immer zuverlässig, und dass man als verdächtig markiert wird, heißt nicht zwangsläufig, dass Fehlverhalten vorliegt. Diese Werkzeuge befinden sich noch in der Entwicklung und können menschliche Texte falsch zuordnen – besonders, wenn sie Muster aufweisen, die oft in KI-generierten Inhalten vorkommen.

Sowohl Studierende als auch Pädagogen sollten die Resultate der KI-Erkennung mit Vorsicht, unter Berücksichtigung des Kontextes und in einem offenen Dialog betrachten. Indem wir verstehen, wie diese Werkzeuge funktionieren und warum es zu falsch-positiven Ergebnissen kommt, können wir einen gerechteren, besser informierten und durchdachteren Einsatz von KI in der Bildung vorantreiben.